2025年2月号

特集1

光電融合技術とスーパーコンピュータの未来

本記事は、2024年11月25〜29日に開催された「NTT R&D FORUM 2024 - IOWN INTEGRAL」における、技術セミナーを基に構成したもので、光電融合技術の最前線について議論された様子を紹介します。

【登壇者】

NTT先端集積デバイス研究所・NTT物性科学基礎研究所

フェロー 松尾 慎治

株式会社Preferred Networks 代表取締役

最高経営責任者・共同創業者 西川 徹

プレゼンテーション1

■パッケージ内光インターコネクションに向けたメンブレン化合物半導体デバイスの研究開発

松尾:最初に、NTTが光デバイスの研究に取り組んでいる目的の1つが低消費電力化です。現在ICT機器が世界的に急増しており、クラウドサービスやAI(人工知能)の普及に伴い、データセンタもGoogleデータセンタのように大型化しています。大型化したデータセンタでは、原子力発電所1基に相当するほどの電力が必要といわれており、こうしたデータセンタは世界で消費される電力の2%を使用しています。日本の場合は首都圏にデータセンタが集中し、国内消費電力の12%を占めています。さらに、NTTは通信・コンピュータ関連を中心に日本の総電力の0.7〜1%を使用していることから、消費電力の削減に向けた研究開発が急務となっています。

私は光技術の専門家なので、光技術の歴史についても簡単に触れておきます。情報の伝送には携帯電話のような無線による方式と有線による方式があります。有線による方式は、銅線に情報が載った電気信号を流す方式と、情報が載った光信号を光ファイバに通す方式があります。電気信号の方式は通信速度が遅いですが伝送距離が短いときはコスト的に有利で、伝送距離が長く通信速度が速い場合は光信号の方式が有利となります。今から40年ほど前に県間網などで使用され始めた光ファイバは、現在では海底ケーブルに至るまで広く使われています。そして、現在では、ICT機器の処理能力が向上し通信速度も高速になってきたため、短距離であっても光信号を使うほうがコスト的に有利な状態になってきており、データセンタやスーパーコンピュータでは平均20 mほどの短い距離でも信号伝送にはほぼ光を使っています。そしてICT機器の性能向上の傾向はさらに顕著なものとなっています。こうした背景をベースに、光電融合デバイスパッケージ内の「光インターコネクション」を中心に、なぜ光が通信の世界だけではなくコンピューティングの世界にも適用されるのかについて説明します。

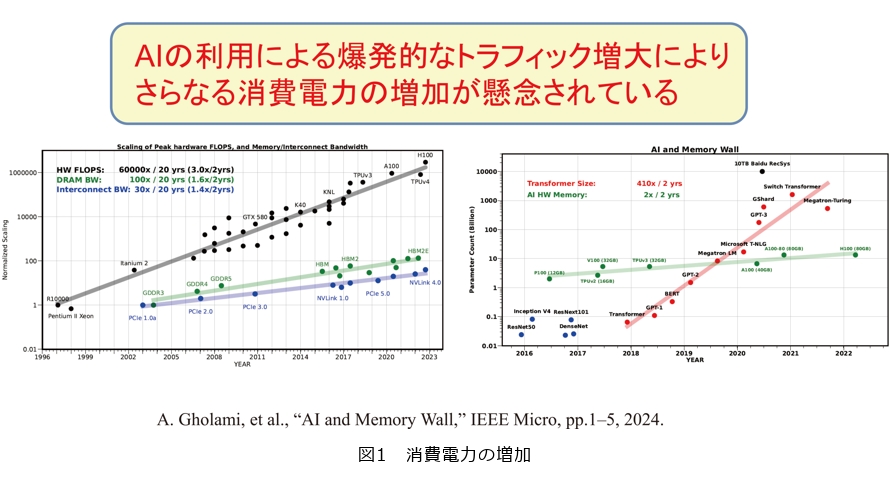

さて、AIの利用が増加することで、トラフィック(通信量)が増大し消費電力も今後さらに増大していくものと予想されています。図1左の黒い線はコンピュータのパフォーマンスの上昇、緑がメモリの伸び、青が通信速度の伸びです。両者の伸びの差をメモリギャップといいますが、メモリギャップが広がる一方です。それをさらに時間を進めたものが図1右です。インターネットの使用量に加え、赤で示すAIがそれを上回るスピードで上昇しており、通信に必要な電力が増加してきています。この短い距離で消費電力の高い部分が、私たちの研究開発のターゲットです。研究開発を進めるうえで留意すべき点としては、スペースに限りがあるため機器は小型であり、そして低消費電力かつ低コストでなければなりません。この3つのポイントを実現させるのが光集積回路です。その実現にあたっては、シリコンのCMOS(Complementary Metal Oxide Semiconductor:相補型金属酸化膜半導体)プロセスを使ったシリコンフォトニクスによりシリコン上に光と電子の集積回路を制作する技術を使います。光通信に必要な光(レーザ光)の送受信素子としてはシリコンではなく「化合物半導体」を使うため、「異種材料集積技術」も重要となります。こうしてつくられた光集積回路がさらに電子デバイスと3次元に集積され、電気と光を密に融合させたものが、「光電融合デバイス」です。

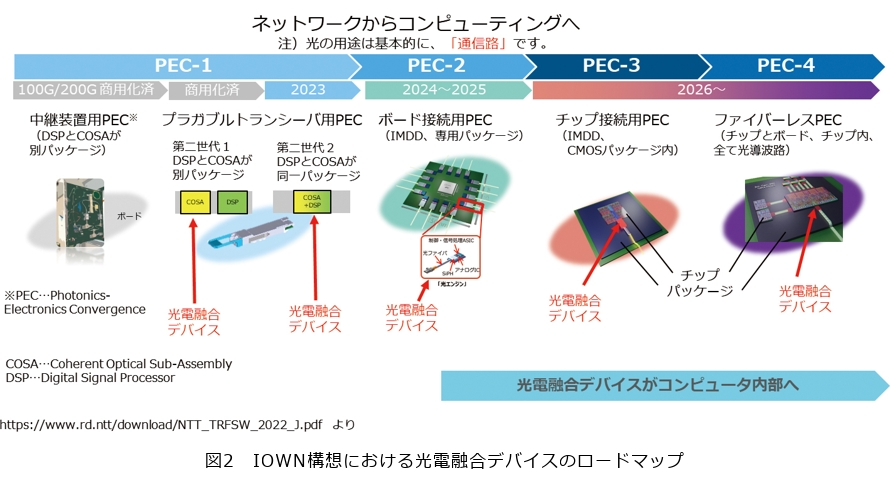

IOWN(Innovative Optical and Wireless Network)構想における光電融合デバイスのロードマップ(図2)では、現在のデータセンタ間からボード間、チップ間、そして最後はチップ内まで光を導入することをめざしています。このため、もう1つポイントとして、チップ単体の機能としては通信、コンピューティングの区別がなくなってくるため、チップ内という極短距離において電気に変わって光が導入されると、今まで通信を専門としてきたNTTがコンピューティングの領域の応用にも入っていく必要が出てくるということになります。

さて、光電融合デバイスのめざす時期は非常に短期間で設定されており、チャレンジングな研究開発です。現実的な課題として、LSI(Large Scale Integration:大規模集積回路)からレーザ光を出す際、電気の配線の部分で膨大なエネルギーが使用されることで無駄が生じており、エネルギー消費の少ない光部分を物理的に寄せて密接させることで無駄を省く取り組みが世界的な流れです。しかし、電子デバイスと比べて、光デバイスは壊れやすく取り替えも困難なため、低コストで耐久性があり、信頼性が高い高品質な光デバイスをつくることが研究課題となっています。

■演算に割り当てられる電力の確保と、「光化」によるハードウェアの物理的な位置に依存しない計算資源の有効利用

次に、LSIの「光化」の必要性について説明します。光化の理由はやはり消費電力が関係するのですが、CPU(Central Processing Unit)チップの消費電力は、性能の向上に伴い一定の割合で増加していることに比べ、オフチップの通信に使われる電力は指数関数的に増加しています。この傾向で消費電力の増加が進むと、コンピュータの本来の目的である「演算」に使用できる電力がなくなってきます。この演算に使う電力を確保するために、「LSIの光化による低消費電力化」が必要になります。

また、一般的なLSIの電子回路は、元々1つのチップ内にCPU、GPU、I/O、メモリ等を構成してきましたが、チップの肥大化やそれに伴う製造上の歩留まりの問題が顕在化したため、チップレット(パーツを細分化して適材適所に活用したもの)により、構成されるようになりました。この場合、「チップレット間の通信」も重要になります。その一般的なLSIのチップレットと、私たちのめざす「パッケージ内の光化(光インターコネクション)」は同じもので、光インターコネクションの導入により、LSIの進化を継続できるのではと考えています(図3)。

さらに、光は2cm飛ばしても、2km飛ばしても伝送損失はほぼ同じで0.2dB程度です。そのためディスアグリゲーテッドコンピューティング(多種類のコンピューティングリソースを、長距離・広帯域・低消費電力な光電融合技術を利用して相互につなぐこと)のようなものが実現できます。実際に米国の企業では、300mmウエハの中に光回線を実装する話も出てきています。

このように光は伝送に適しているため、距離が長くなるほど光を使う可能性が高くなります。またNTTが提案しているディスアグリゲーテッドコンピューティングでは、メモリ不足解消のためいろいろな個所からメモリを集めてスケーラブルにしており、ボード上の電気では対応できない領域をターゲットとしています。

■半導体とシリコンを集積した「光電融合デバイス」の重要性

さて、前述のとおりシリコンでは電子回路をつくれても、レーザ光はつくれません。現在、レーザ光を出すデバイスをシリコン上に配置する方式が一般的ですが、光ファイバに相当する0.5μm幅の光導波路に光を通すために、レーザデバイスの発光部と光導波路の位置を合わせる必要があり、それに非常にコストがかかります。今回のR&Dフォーラムではウエハレベルでつくれることを紹介していますが、従来のレーザデバイスをより薄膜にすることで多くのメリットが生まれました。その結果、シリコンフォトニクスと非常に相性の良い光電融合デバイスが出来上がりました。現在では16 chのレーザアレイを置いて1.6Tbit/sの信号を出すところまで研究開発が進められています。

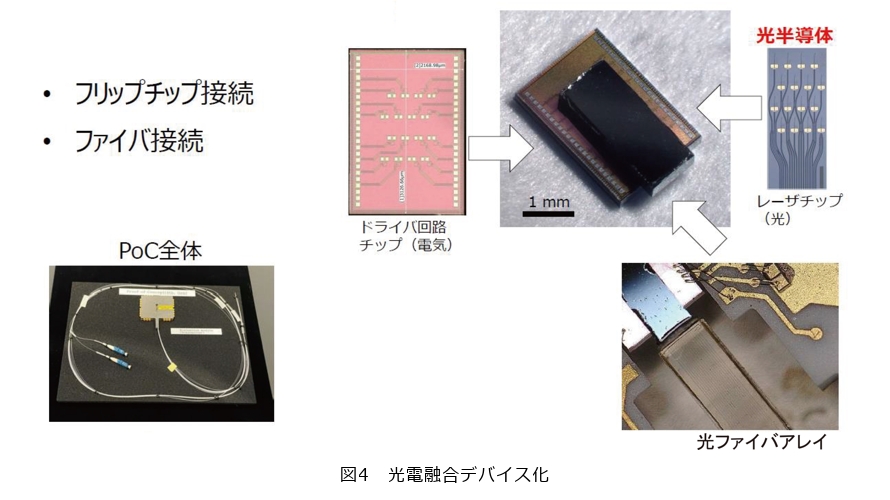

そこには光電融合デバイスが重要で、そのチップとCMOSのドライバサーキットを3次元的に集積することで、回路間の距離が短く非常に低消費電力のものができます。このとき低価格で早く低消費電力化を実現するために、電子回路と光回路を別々に設計せずトータルで考えることが大事であり、これからはこの光電融合デバイス化が非常に重要な技術になると考えています(図4)。

プレゼンテーション2

■サステナブルなAIをめざして

西川:NTTグループとAI分野で業務提携しているPreferred Networksの西川です。私たちはまだ「光電融合技術」は使っていませんが、生成AIや基盤モデルといったインターコネクトを非常に重要とする世界において、これからは間違いなく低消費電力や低コストでの製造は重要になってくると考えています。

また、これまでの機械学習AIに比べて生成AIのようなAIは、計算インセンティブによりアーキテクチャのバランスが変わり、アーキテクチャそのものも変わってきています。ここでは、私たちはこうした変化の中で、どのようなアーキテクチャをめざすべきなのかについて説明します。

まず、私たちはソリューション・製品、生成AI・基盤モデル、計算基盤、そしてそれを動かすためのAIチップの制作など、垂直統合型で4階層の技術をつくっています。取り組みの理由として、生成AIや基盤モデルはポテンシャルが分からない部分が多くあり、さまざまなレイヤを研究開発して機動力よくそのポテンシャルを突き詰めていくフェーズだと考えており、4階層をバランスよく研究開発しています(図5)。

そして、先ほど松尾フェローから話がありましたように、現代では消費電力が非常に大きな問題になっています。最先端AIシステムに求められる計算力は指数関数的に上がり、世界最高性能のスーパーコンピュータの計算能力を遥かに超える状況になっています。AIのポテンシャルが高くなる反面で、消費電力やコストも上がり、高度なAIを使うことでエネルギーは低減できても、それを上回る大量の電力を使用するという矛盾を抱えている状況です。AIを研究する者としては、この消費電力をいかに減らすかということも非常に重要です。その打開策として、私たちは2016〜2019年に「MN-Core」という専用AIチップを開発し、2020〜2023年にはバージョン2を発表しました。

そもそもなぜAIチップを開発したのかというと、AIに使用されるGPUの不足が当時から問題で、出荷量が10万あったとしても不足していました。そして、AIにとって計算力や消費電力が大切な生命線であり、この生命線をいかに確保するのかが非常に重要な課題でした。この心臓部分を確保するため、自分たちで開発を始めました。

省電力化の方法としては、トランジスタの多くの部分を演算器とSRAM(Static Random Access Memory)と呼ばれるオンチップメモリで占めて、制御回路は最小限にしてソフトウェアに任せることにより、大幅な電力の低減に成功しました(図6)。

現在はこれを社内で使用しており、推論であれば軽い部分であっても、学習の部分は非常に重いといったように、このアンバランスさが性能に大きな影響を与えてしまうことが分かり、アーキテクチャを工夫することによって性能を確保しつつ低消費電力で、低価格なプロセッサをつくれると考えています。現在は第3世代、第4世代の開発に着手しており、2026年からは販売を予定しています。

それに加えて、MN-Coreのソフトウェアに関してはコンパイル(プログラミングコードを機械語に翻訳変換すること)にも注力しており、開発においてソフトウェアとハードウェアをうまく融合させることで、対応するAIモデルの数を日々増やしています。さらに、それに対して高度な解析・最適化を行うことにより、新しいモデルへの対応を日々生み出しています。

少し前の話になりますが、私たちが開発したものが、同じプロセスルールにおける「コンピュータランキング」の世界1位を計3回獲得できました。非常にエキセントリックなアーキテクチャなのですが、ソフトウェアとハードウェアの融合を工夫することにより、使いやすさとコストパフォーマンスを兼ね備えた「新しいアーキテクチャ」であると証明できたと思います。

今後のロードマップでは、アーキテクチャの仕様が大きく異なる「推論」と「学習」を2つに分けて、それぞれに最適なアーキテクチャの実現をめざしています。例えば推論はほとんど演算を使わず、メモリやインターコネクトなどを多用するため、光電融合のような高速で低消費電力な仕組みが必要です。こういったものを組み合わせていくことにより、より優れたアーキテクチャを実現し、今後特にLLM(Large Language Models)をはじめとするチップの世界の発展にさまざまな側面から寄与していくのではないかと思っています。

このように、現在はパッケージングをはじめとする新しい技術を用いて、柔軟かつ用途に応じた適切なプロセッサづくりに取り組んでいます(図7)。

スーパーコンピュータ的な大型の計算機は複雑なエコシステムにより形成されるのですが、日本の中で優れたエコシステムを構築し、どんどん新しい技術を取り込みながら成長させていくことが重要だと考えています。

これからは「計算機をスケールする技術」もますます重要になります。もちろんLLMにおける計算機のスケールも重要ですが、LLMだけでAIの世界が終わるわけではありません。計算機の高速化によってできることが増えてきており、それを実現するためには高効率のAIチップとインターコネクトやチップレットをはじめとするさまざまなエコシステムや技術のインテグレーションが必要だと考えています。

ディスカッション

■MN-Coreをつくるまでの経緯

松尾:演算に使う電力が圧迫されてくる中で、不要なものを外に出し、ソフトウェアで制御して演算にスペースを与える、という考えに非常に感銘を受けました。私の知っている限り、Preferred Networksは検索エンジンやAIを開発していたと思うのですが、MN-Coreの開発が重要だと考えた経緯をもう少し詳しく聞かせてください。

西川:2016年当時、日本ではGPUの入手が非常に困難で、私たちは何とか1024枚のGPUを購入できたのですが、入手するまでの交渉は非常に厳しいものでした。日本でもアーキテクチャを研究開発・販売する企業はありましたが、ソフトウェアで弱い部分があるためGPUを代替できるものではなく、このままではいずれGPUが手に入らなくなると思いました。さらに、ディープラーニングの中でも私たちが理想とするワークロード(コンピュータにかかる処理負荷の大きさ)を実現する目標がありましたので、それならば自分たちの理想とするアーキテクチャを自分たちでつくろうという流れになりました。それに加えて、私がハードウェアをつくることに魅力を感じていたことも大きいと思います。大学時代、ハードウェアが専門の指導教官の研究室にいたのですが、その先生は当時スーパーコンピュータが1000億円かかる時代に「20億円で低消費電力のプロセッサをつくるぞ」と話をされていたことが私の中では衝撃でした。結果的に、所望の性能を出すのは難しかったのですが、かなり良い性能を出せました。このような流れの中で、スーパーコンピュータをつくることはとても面白いことだと感じて、この世界に入り、こうした流れの中でMN-Coreの開発につながったと思います。

松尾:スーパーコンピュータをつくるなど、ハードウェアをつくるときは設計がとても重要になります。Preferred Networksはソフトウェアの研究者が多いと思いますが、ハードウェアの研究をどう加速していくのか、人を集め会社的に成果を出していく際に心掛けていることはありますか。

西川:現在ハードウェアを開発しているメンバは80人ほどおり、どれだけ入念に検証するか、ということに注力しています。ハードウェアのテストベクタ(設計内容を評価するデータ)やテストケースを書くときもいろいろなパターンを試行錯誤し、できる限りバグによるトラブルが発生しないようにしています。もし、バグが発生したとしてもどうやってそれを修復してトラブルを防ぐかというワークアラウンドに力を入れています。

■未来のスーパーコンピュータとAI

松尾:メモリ不足の問題では、メモリとCPUを3Dで積層して、通信のエネルギーや速度帯域を上げる話をされていました。先ほどNTTのディスアグリゲーテッドコンピューティングについて話をしましたが、データセンタ全体を使用したコンピューティングはAIで使えるものがあるのでしょうか。

西川:データセンタ自体の性能を上げていくことはもちろん、スーパーコンピュータの設計にAIを活用することも重要だと思っています。スーパーコンピュータは非常に複雑なシステムで、その複雑さは今後増していくといわれています。その複雑化したスーパーコンピュータを安定して動かすためには正確な設計が大事で、それを人間が行うのは非常に難しいことです。そこでAIの活用が期待でき、これからはAIと人がどのように協調してコンピュータをつくるのかというプロセスを構築することが重要だと思います。

松尾:AIがあまりに膨大に設計してしまい、その正誤判定や検証を人間が行うのも難しく、AIに判断を任せると間違ったものを正しいと判断する可能性もあります。この対策はどうするのでしょうか。

西川:私も同じ問題意識を持っています。この対応については、正誤判定や検証にAIを活用するためには、最初は小さな回路から順に育て、ノウハウを積み上げることが必要です。今後はコンピュータがコンピュータを設計するという流れになると考えています。そこでは、人間にできること・できないことを、切り分けなければなりません。最初はその切り分け自体が職人芸になると思います。それをうまく使いこなして新しい設計手法を見出していくことが、新たな半導体をつくるうえで非常に重要であり、ほかにも複雑化するパッケージングの階層や、排熱の難度が高くなり、また、半導体のレイヤどうしのインテグレーションなど、人間では難しいことがたくさん出てくると思いますが、そこまで踏み込んで設計することで「日本にしか出せない価値」があると考えています。逆にいえばそこまでいかないと、日本でも半導体をつくる際の、勝ちシナリオを見つけるのは難しいと思います。

松尾:ディスアグリゲーテッドコンピューティングにも関するところですが、私たちの今の課題は、コンパクトなLLMと大きなLLMでは、ボードのつなぎ方で必要なアーキテクチャが異なるということです。臨機応変に使えるアーキテクチャがなければ、将来のスーパーコンピュータを効率的に動かすことができないと思います。そこでMN-Coreのつくり方についても伺いたいのですが、1個で全部の計算をするのか、それとも何個もつないで計算するのでしょうか。

西川:MN-Coreのバージョン1は4つの台をつなげ、バージョン2は1つの台になり、現在のバージョン3は密度を高める方向に移っています。そして、推論と学習を分けることで、効率良く動けて容積的にも短く小さくすることが重要で、これにより効率的な推論に本当に必要な演算量は10分の1とか20分の1くらいまで下がります。工夫しながら小型化・効率化をめざしています。また、電力の供給だけではなく排熱も重要なため、シミュレーションを駆使して排熱と電力消費のバランスを考えながら研究開発を進めています。

会場へのメッセージ

■AIで省エネができる世界をめざす

松尾:ハードウェアの研究は当たり、はずれが多いため手探りの状態になりやすく、そのため結果に向けて一生懸命やるのはとても大変なことです。私たちは世の中に役立たせるため、パートナー企業とともに非常に苦労して進めていますが、NTTの研究所は公共的な部分を求められるところがあるので、地球全体、社会全体を考える必要があります。エネルギー消費についても、極端な話をすると、インターネットを使わなければエネルギーを消費せずに地球に優しくなれるのですが、ただそれだけの話に終始してしまい非現実的です。そこを打ち破れるのがAIだと思っています。現在はAIのエネルギー消費が問題視されていますが、これからはNTTやPreferred Networksの技術を使い、AIで省エネルギー化ができる世界をめざすことが大事だと思います。また、AIはデバイスなど設計分野以外にも活用できると考えています。例えば工場のライン管理などでも活用でき、AIがモニタを監視して何かあればアラームを出して修正する、などサステナブルな工場ができ、それにより消費電力抑制にもつながるのではないか、といったようなAIの可能性も広がるのではないかと思います。

西川:ハードウェアとソフトウェアの合わせ技、そのバランスがスーパーコンピュータにおいてますます重要になると思います。私たちはよく「何をしている会社なのか」と聞かれるのですが、ハードウェアとソフトウェアをバランスよく融合させることで起こせるイノベーションをめざしています。そのためには両方研究していなければいけません。AIによる自動化もいずれ鈍化するかもしれませんが、一方でエンタテインメントや新しいデバイスなど、低消費電力で新しい素材を使ったエッジデバイスの世界観は、これからも生まれ続けると思います。また、ハイブリッドで人々を豊かにしていく会社はほとんど日本にはないとも思われる中で、NTTの取り組みは非常に素晴らしいもので、とても感銘を受けています。