2022年5月号

特集

レーン別渋滞検知技術

- レーン別渋滞

- コネクティッドカー

- 交通流最適化

自動運転やナビゲーション高度化を目的とした、高精度な地図情報に交通規制・渋滞等のさまざまな情報を重ねたダイナミックマップの構築が進められています。これらの実現にあたり、NTTでは、商業施設の駐車場への入庫待ちや右左折レーン車列の車両群など、レーン単位の渋滞車列を検知し情報提供することで、これまでにない高度なナビゲーションを実現できると考えました。本稿ではコネクティッドカーの収集可能な情報からレーン単位の渋滞車列を検知する技術について述べます。

森 皓平(もり こうへい)/横畑 夕貴(よこはた ゆき)

林 亜紀(はやし あき)/秦 崇洋(はた たかひろ)

神谷 正人(かみや まさと)

NTTスマートデータサイエンスセンタ

はじめに

近年、自動運転やナビゲーション高度化を目的とした、高精度な地図情報に交通規制や渋滞などのさまざまな情報を重ねたダイナミックマップ(1)の構築が進められています。これらの情報はリアルタイムにダイナミックマップ上にマッピングされることで、道路交通上の状態を把握することができ、交通流を最適化するナビゲーションなどのサービス実現が期待できます。しかし現実には交通規制や渋滞などの情報をリアルタイムかつ全国の道路を網羅的に検知する手段が必要です。例えばミリ波レーダ(2)やトラフィックカウンタ(3)により定点における通過車両の流量を計測し渋滞を検知することができますが、これらは渋滞が想定される個所に機器を設置する必要があり網羅性に欠けます。またスマートフォンなど、運転者の端末を利用し車両速度から網羅的に渋滞を検知する方法(4)も提案されていますが、これらは車線レベルの分解能を備えていません。しかし、現実の交通においては商業施設の駐車場の入場待ち車列や、高速道路出口の車列、交差点の右左折レーンの車列といった車線単位の車列がさまざまな場所で発生します。こうした車列に遭遇したドライバは、特に土地勘のない道路では目的地へ到達するために、これらの車列に並ぶ必要があるのか判断することが難しく、不必要にもかかわらず車列に並んでしまう場合や、本来は並ぶべき車列を通り過ぎることによって目的地へ遠回りしてしまう場合があります。

そこで私たちは、車線単位の車列(レーン別渋滞)や、その区間を検出することができれば、運転者の目的地に応じて並ぶべき車列と並ぶ必要のない車列を判断し、レーン別渋滞を回避しつつ目的地へ案内するレーンレベルナビゲーションなど、これまでにない高度な運転支援を提供することができると考えました。本稿では、一部のコネクティッドカーが得た映像データとその車速からレーン別渋滞を検知する技術(5)について述べます。

レーン別渋滞検知技術

■定義

一般道路における既存サービスで用いられている渋滞の定義(6)を参考に時速10km以下かつレーン単位の車列をレーン別渋滞と定義し、検知対象は同既存サービスにおける渋滞長定義を参考に、その10分の1以下である42m以上のものとしました。また本稿では、データを取得するコネクティッドカーを観測車両、観測車両が搭載した車載カメラで撮影した映像に映った観測車両以外の車両を他車両と呼称します。

■処理概要

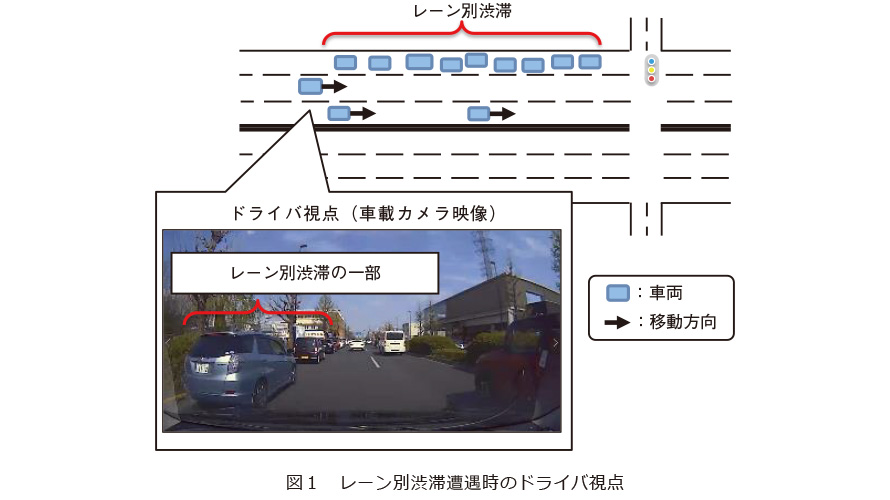

レーン別渋滞に遭遇した際の道路状況イメージと車載カメラ映像を図1に例示します。観測車両の撮影した車載カメラ映像から、観測車両が追い抜いた他車両や対向車線ですれ違った他車両の台数をカウントすることで、観測車両の車速と両台数・換算した他車両の密度からレーン別渋滞を検知することができます。レーン別渋滞を検知した場合は評価期間をずらして再度評価するという処理を繰り返してレーン別渋滞が続く区間を推定し先頭車両と末尾車両を特定可能です。

■処理フロー

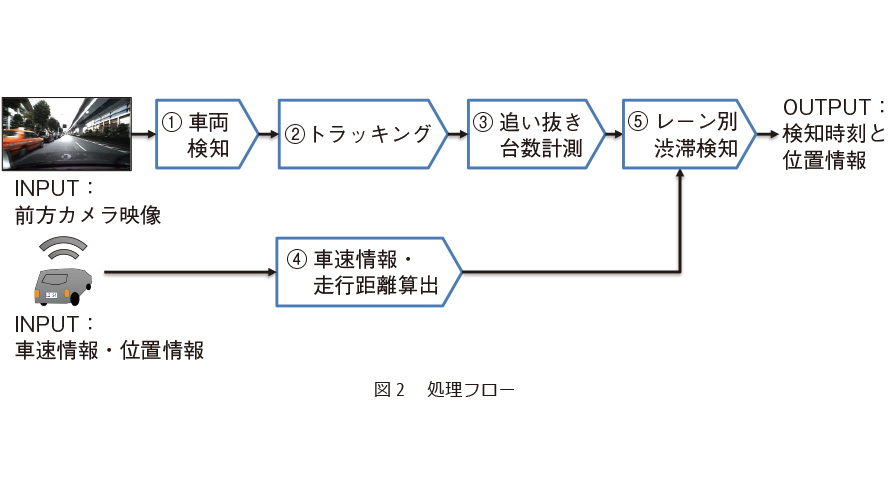

前方カメラで観測車両の前方を撮影した映像を取得し、図2に示す各処理を実施します。

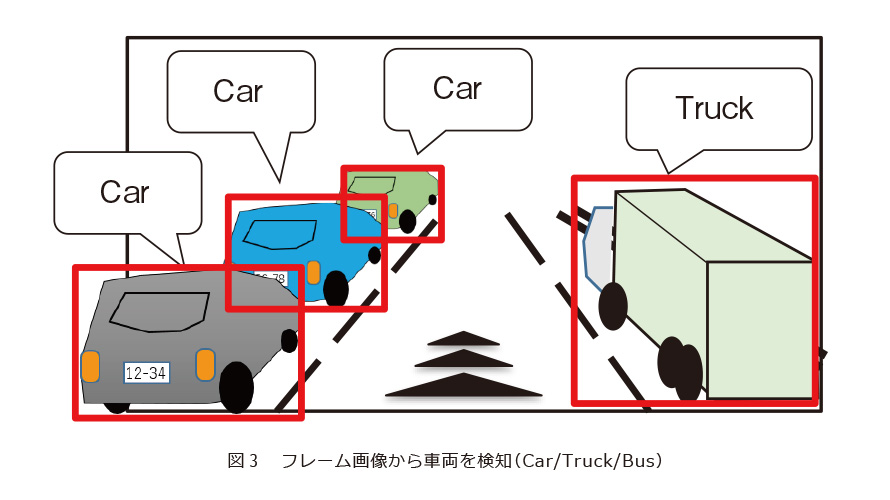

① 車両検知

取得した映像をフレームごとの画像に分割し、物体検知技術(7)を用いて各フレーム画像に映り込んだ他車両を検知します。検知の結果は矩形(検知矩形)で表現され、対象の車種に応じてCar/Truck/Busの3種にラベル付けします(図3)。

② トラッキング

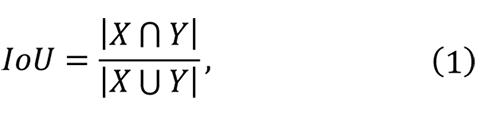

観測車両と他車両の相対位置は変化するため、他車両のフレーム画像間の移動を追跡しナンバリングします。次に各フレーム画像で他車両に適当なナンバーを割り当て、現フレームNの検出矩形Xとそのfフレーム前(フレームN−f)の検出矩形Yの一致度を、2つの集合の類似度を測る指標Intersection over Union(IoU)

を用いて評価します。このときIoUがもっとも大きい、つまりもっとも共通する画素の多い検知矩形どうしを同一の他車両によるものと見なすことでトラッキングし軌跡を求めます。

を用いて評価します。このときIoUがもっとも大きい、つまりもっとも共通する画素の多い検知矩形どうしを同一の他車両によるものと見なすことでトラッキングし軌跡を求めます。

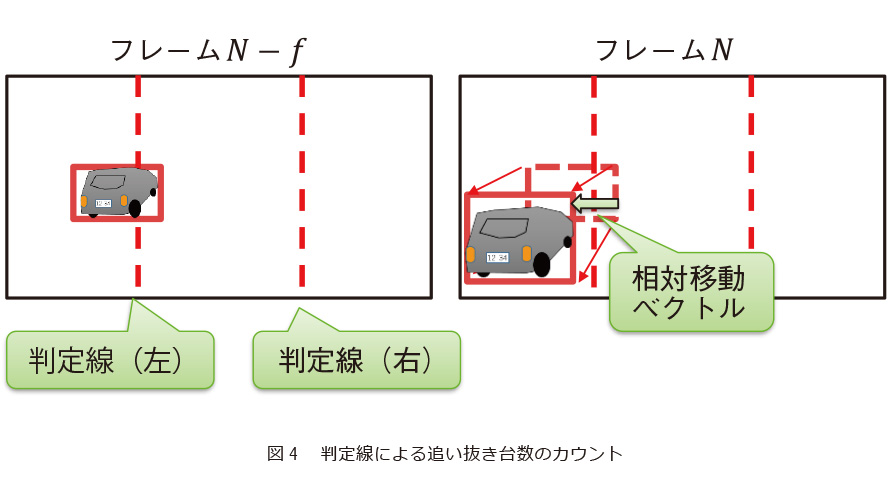

③ 追い抜き台数計測

フレーム画像間で共通する判定線を設定します(図4)。次にトラッキングで求めた他車両の軌跡について相対移動ベクトルとして表現し、この対移動ベクトルのうち道路消失点から画像外側に向けたものが判定線と交差した際に観測車両が他車両を追い抜いたとカウントします。

④ 車速情報・走行距離算出

取得した車速情報から観測車両の走行距離を算出します。

⑤ レーン別渋滞検知

評価期間ごとの追い抜いた車両の台数に関するしきい値が明確でないことから、現状では追い抜いた車両の密度(車両密度)を用います。少なくとも車間距離は通常どおり走行している場合と比較して短く詰まった状態にあるものと考えられるためです。

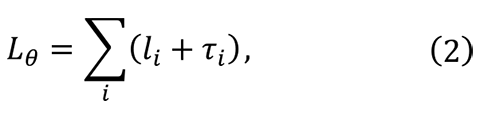

他車両を追い抜いた台数から、隣接レーンにおいて車両が占める距離のしきい値(占有距離しきい値Lθと呼称)を追い抜いた他車両iの全長liと車両iの前方車間距離τiとして次のとおり求めます。

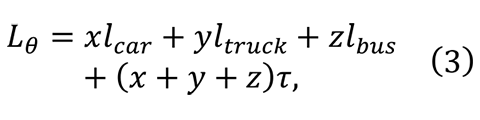

さまざまな全長の車両が存在しますが、簡単のため学習モデルにおいて判別する3クラスについてCarの全長lcar = 4.8m、Truckの全長ltruck = 12.0m、Busの全長lbus = 12.0m を用いて算出します。車間距離τは“車両が詰まった状態”ではあるが急ブレーキが間に合う距離が妥当と考え、クラスによらずτ = 5.0mとします。なお渋滞の定義の上限である時速10km(秒速2.778m)では停止距離(空送距離+制動距離)が足り、混雑の定義の上限である時速20kmでは不足する値です。反応時間は一般的な値とされる0.75秒、摩擦係数は乾いた路面を想定し0.7としました。空走距離:秒速2.778m×0.75秒=2.08m制動距離:(10×10)÷(254×0.7)≒0.56m追い抜いた車両のクラス(Car/Truck/Bus)ごとにx、y、z とすると、

さまざまな全長の車両が存在しますが、簡単のため学習モデルにおいて判別する3クラスについてCarの全長lcar = 4.8m、Truckの全長ltruck = 12.0m、Busの全長lbus = 12.0m を用いて算出します。車間距離τは“車両が詰まった状態”ではあるが急ブレーキが間に合う距離が妥当と考え、クラスによらずτ = 5.0mとします。なお渋滞の定義の上限である時速10km(秒速2.778m)では停止距離(空送距離+制動距離)が足り、混雑の定義の上限である時速20kmでは不足する値です。反応時間は一般的な値とされる0.75秒、摩擦係数は乾いた路面を想定し0.7としました。空走距離:秒速2.778m×0.75秒=2.08m制動距離:(10×10)÷(254×0.7)≒0.56m追い抜いた車両のクラス(Car/Truck/Bus)ごとにx、y、z とすると、

この占有距離が観測車両の走行距離Dよりも長い場合

この占有距離が観測車両の走行距離Dよりも長い場合

は車間距離が定めたしきい値よりも狭い状態、つまりレーン別渋滞の状態であると判断します。

は車間距離が定めたしきい値よりも狭い状態、つまりレーン別渋滞の状態であると判断します。

■その他工夫点

精度向上のため、車両検知における逆光や映り込みに起因した物体検知漏れ対策としてカルマンフィルタを用いて他車両の移動先を予測し補完する処理を追加しました。また対向車線の他車両とすれ違う場合を判別するため、各他車両に対しフロント(車両前部)・リア(車両後部)判定処理を実施し、観測車両に対してフロントを向けた車両が多い場合は「対向車線の他車両とすれ違った」と判別し先頭車両と末尾車両を入れ替える処理を実施します。

実証実験

■実験概要

東京都港区台場地区を走行した実験車両を観測車両として、レーン別渋滞検知の精度評価を実施しました。走行ルートは図5に示す赤実線と青点線の2種です。事前調査により、これら走行ルート上には自然発生したレーン別渋滞が高確率で存在することが判明しています。車内前方上部に設置したカメラを用いて1920×1080pxの解像度で撮影した映像を10fpsで保存し、位置情報はGPSを用いて緯度・経度を1秒間隔で取得しました。速度情報は位置情報の変化から換算し代用します。

■レーン別渋滞の検知精度評価

レーン別渋滞の存在を目視で確認した動画(48動画・各60秒)を対象に実施した精度評価について述べます。

(1) 目視確認内容

42m以上の渋滞長のレーン別渋滞が検出対象となるようCar3台+Truck1台等の他車両の組合せを連続して追い抜くシーンを目視で確認し抽出し正解データとしました。

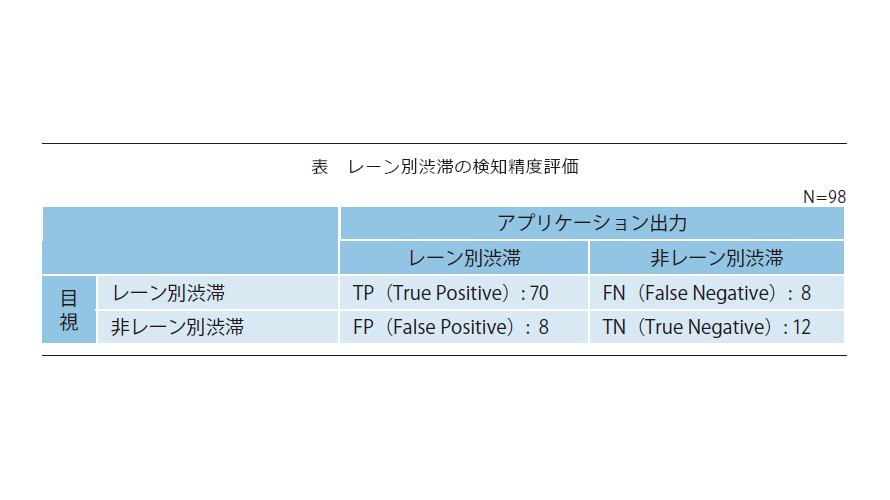

(2) 精度評価内容

目視確認とアプリケーション出力の結果を比較した混同行列を表に示します。精度Precision(TP/(TP+FP))は89.7%で、FPの主要因は「駐車場等の敷地内に停車している他車両の影響」が3件、FNの主要因は「対向車線のレーン別渋滞について、ガードレール等の陰に他車両が隠れてしまい物体検知ミスが発生した」が4件でした。またFP/FN双方に共通する要因として「物体検知漏れ」と「他車両の占有距離が固定値のため誤差が生じた」、「位置情報に誤差があり観測車両の移動距離が不正確」でした。

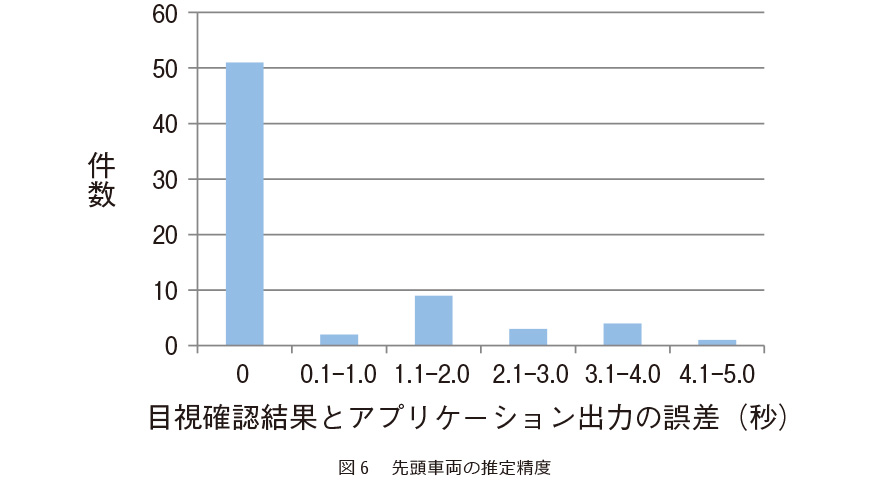

■先頭車両の推定精度評価

目視確認・アプリケーションの出力ともにレーン別渋滞だと判断したTP:70件のシーンについて追加評価を実施しました。目視確認とアプリケーションにおいて、観測車両が先頭車両を追い抜いたと判断したフレームを比較した誤差についてまとめた結果を図6に示します。誤差の平均値は0.57秒、中央値は0秒、最大値は4.1秒という結果でした。各走行ルートは制限速度が時速50kmのためCar1台を追い抜くのに要する時間は車間距離を考慮して約0.7秒となり、平均値0.57秒は許容範囲だと考えています。誤差が前後1.6秒以上となった14件について調査したところ「位置情報に誤差があり、観測車両の走行距離を誤認し処理を継続/中断」9件、「物体検知時のCarとTruckの誤認」3件が主な要因でした。

おわりに

単一のコネクティッドカーから収集可能な映像データと車速や位置情報からレーン別渋滞を検知し先頭・末尾車両を特定するレーン別渋滞検知技術を実現しました。また実証実験として、前方カメラ映像と位置情報から検知精度と先頭車両の推定精度を評価した結果を紹介しました。今後の課題は精度の向上と、レーン別渋滞の要因を特定する手法について検討していきます。

■参考文献

(1) 小山・柴田:“自動走行におけるダイナミックマップ整備,”システム制御情報学会解説記事,Vol.60, No.11, pp.463–468, 2016.

(2) https://www.c-nexco-het.jp/tech/detail/0048.php

(3) https://info.hitachi-ics.co.jp/product/gazoutraffics/

(4) 渡部・金澤・澤:“スマートフォンを活用したプローブ情報収集システムの開発,”国土交通省技術研究会論文集,pp.221–226, 2013.

(5) 森・横畑・林・秦・尾花:“レーン別渋滞検知技術の提案とフィールド実験への適用評価,”情報処理学会論文誌, Vol.63, No.1, pp. 163–171, 2022.

(6) https://www.jartic.or.jp/s/attention/inquiry/#map_8

(7) https://github.com/pjreddie/darknet

(上段左から)森 皓平/横畑 夕貴/林 亜紀

(下段左から)秦 崇洋/神谷 正人

今後普及が見込まれるコネクティッドカーは、道路交通上の状態を網羅的に計測する手段として有効です。今後はレーン別渋滞の検知精度向上にとどまらず、その他の事象も計測できるよう技術を拡充していく予定です。