2023年11月号

挑戦する研究者たち

神経反射による腕運動とそのときの脳内感覚運動情報処理の関係、およびそのメカニズムを解明

私たちの何気ない日常の動作においても、伸長反射に代表されるように、無意識の脳神経系の情報処理プロセスが関与して巧みな運動制御が行われているものが多くあります。このような無意識で行われる感覚-運動系には比較的原始的な神経システムが関与していると思われるかもしれませんが、高次の視覚情報処理が行われた信号をトリガーとして反射的応答が発現するものもあります。その一例である、視覚運動から短潜時で腕応答が生成されるメカニズムに関して、仮説検証により世界で初めてメカニズムを明らかにした、NTTコミュニケーション科学基礎研究所 五味裕章上席特別研究員に、神経反射による腕運動とそのときの脳内感覚運動情報処理の関係、およびそのメカニズム、楽しく研究を進める思いと工夫を伺いました。

五味裕章

上席特別研究員

NTTコミュニケーション科学基礎研究所

人間の脳内の感覚運動情報処理を解明し、新しいインタフェースを創出する基盤構築をめざす

現在、手掛けていらっしゃる研究について教えていただけますでしょうか。

新しい潜在感覚運動系の発見や情報処理解明・モデル化を通じて、人にやさしいインタフェース創造に向けた基盤構築をめざして研究に取り組んでいます。

前回(2020年12月号)は、人間が無意識に行っている身体動作の1つであり、筋の受動的な伸びによって運動指令が生じる「伸張反射」の生成において、体性感覚情報だけではなく、視覚情報も統合した脳内の身体表象(脳内でイメージされている身体)を使った情報処理により調整されることを世界で初めて確認したことを紹介しました。さらに、体性感覚の実際の応用例として、体性感覚の1つである指の触覚を特殊な振動で刺激することによって、「引っ張られている感覚」を知覚させてナビゲートなどができる小型機器「ぶるなび」を紹介しました。

現在は、対象物に手を伸ばす際に使われる脳の情報処理のメカニズム解明に取り組んでいます。といっても急に始めたわけではなく、実はかなり以前からこの問題と向き合っています。脳は視覚や触覚、筋に埋め込まれたセンサなどからの情報をどのように使って外界を表現し、筋骨格系を動かしているのでしょうか。感覚情報にちょっとした細工をすると、知覚や運動に不思議な影響が現れます。それらの現象は時には意識にも上るときもあれば、気付かずに起こることもあります。

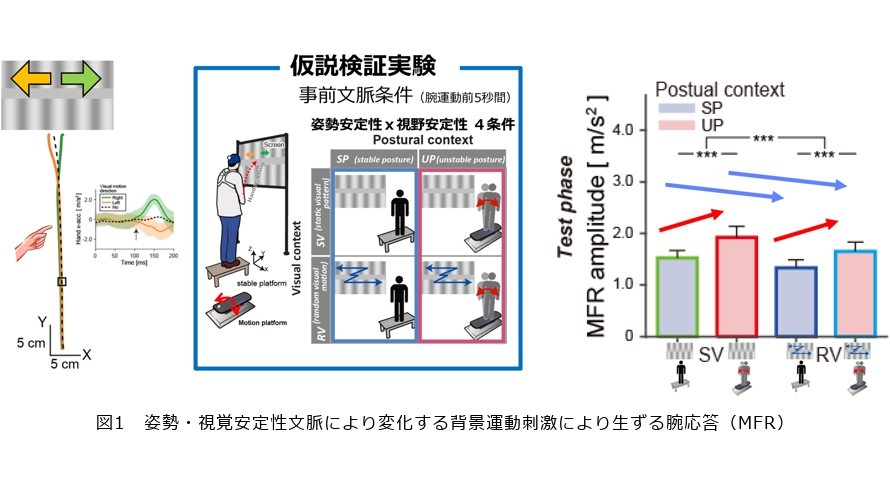

例えば、手を動かしている最中に、目の前の白黒パターンを左に動かすと手が勝手に左に、右に動かすと勝手に右に動いていくというような運動が出ます。それは自分が自ら動かしているわけではなく、自分の意思にかかわらず、手が勝手に視覚情報に従って動いてしまう「視覚情報によっておこる反射」(MFR:Manual Following Responseと命名)と考えられます。こうした運動を生成するような情報処理が脳にある、ということを私たちが20年ほど前に発見して、その情報処理がどうなっているかについて調べてきました。この現象を説明するには2つの考え方があります。他の研究グループが提案した仮説は、自分が手を伸ばそうとする先のターゲットの脳内の表象がこの視覚運動によってズレたために、手の修正動作が起った、というものです。私たちの説は、視野に広がるパターン(白黒パターン)が動いたことによって自分の体が動いたと錯覚し、それに対する補償動作として手が動いた、というものです。ところが、これらの説のどちらが正しいのかということは最近まで検証が十分できていなかったのですが、私たちがある実験によって検証を行うことに成功しました(1)。

その仮説検証実験では、安定的な台に人が乗り、目の前でグレーティングパターンを静止させた状態とランダムに動かした状態(姿勢安定性)、そして不安定な台に人が乗り、目の前でグレーティングパターンを静止させた状態とランダムに動かした状態(視野安定性)の4条件を設定し、それぞれの条件が視覚運動で生ずる手の応答(MFR)の大きさにどのような影響を与えるかを比較しました。私たちの仮説に基づくMFRの振幅変調を、視覚運動から姿勢変化を推定するベイズモデルを使って計算すると、姿勢が不安定になるとMFRが大きくなり、視野が不安定になるとMFRが小さくなるという予想になります。実際の実験結果は、ベイズモデルによる予想と一致しており、MFRは姿勢変化に対する補償動作であること(仮説)が裏付けられました(図1)。

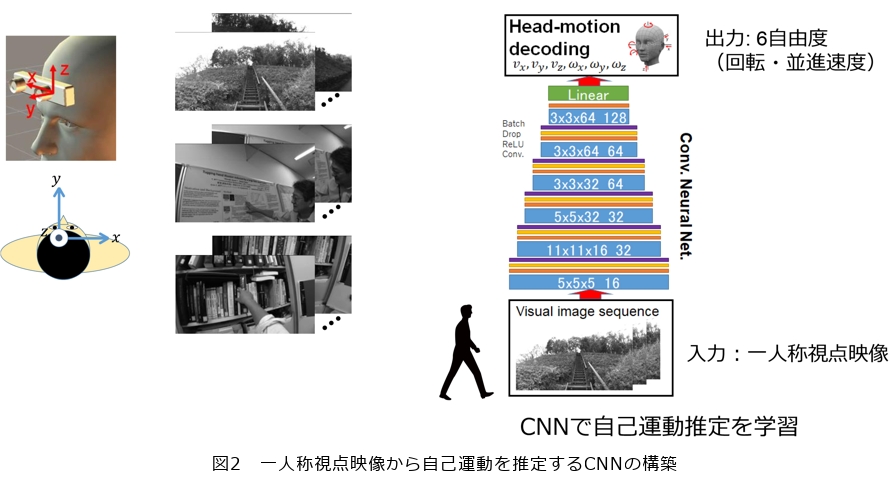

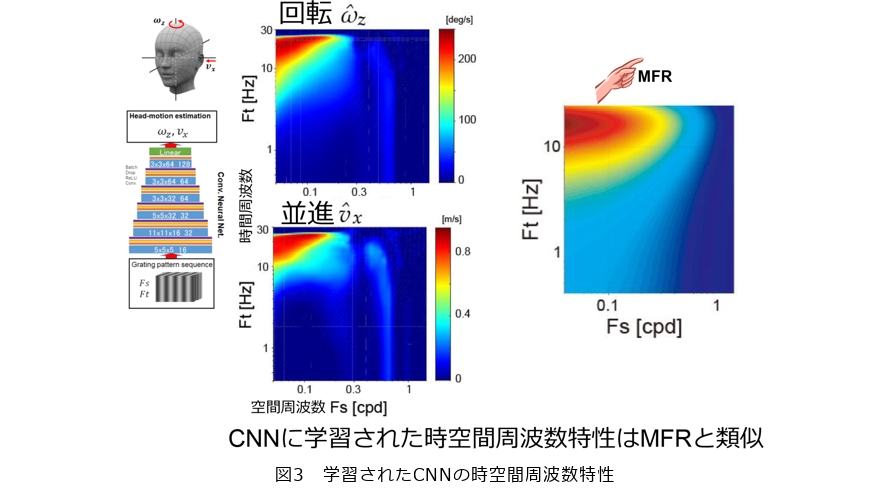

さらに、その実験で実証された「MFRは姿勢変化に対する補償動作である」ことと、これまでの研究で明らかにした「脳の視覚運動解析は、MFR生成に関与する」ということを結び付けて、「MFRのための視覚運動解析は自己運動(姿勢の動き)を推定するために形成される」という仮説を立て、この仮説を構成的に検討しました。まず、モーションセンサ内臓のヘッドマウントカメラを装着して屋内外の歩行シーン、ポスターを見ているシーン、本に手を伸ばしているシーンなど、30〜70秒の映像(一人称視点映像)を撮影し、次にそれらの映像を入力としてそのときのカメラの動き(すなわち自己運動)を推定するCNN(Convolutional Neural Network)を使って深層学習させてみました(図2)。

学習が完了したCNNに未学習の一人称映像を入れると、その出力は自己運動の実測値とほぼ一致しており、自己運動中の一人称視点映像のみから、6自由度の回転・並進速度で構成される自己運動を逆推定できることが分かりました。興味深いことに、このCNNの中間層の特性を調べてみたところ、これまでに明らかにされている脳の視覚解析処理を担う細胞と近い情報処理特性を持つことも分かってきました。また、学習されたCNNの時空間周波数特性を調べると、MFRの時空間周波数特性と類似していることが明らかになり、さらに詳細な解析によりMFRが並進方向の自己運動の推定値を使って生成されていると考えられることが示唆され、「MFRのための視覚運動解析は自己運動を推定するために形成される」という仮説が支持されました(図3)。これらの研究の進展により、人間の視覚情報から潜在的な運動を生成するメカニズムの一端の理解が深まったように思います。これらの結果は、2023年に“Neural Network”に論文掲載されました(2)。

「ぶるなび」で面白いアプローチができたそうですね。

前回紹介させていただいた、触覚を刺激することによって、「引っ張られている感覚」を実感させてナビゲートする「ぶるなび」については、その振動触覚情報がどのように脳の中で引っ張っていると感じているかについての研究を進めました。振動をいろいろ変化させて引っ張られる感覚が変化する際の脳波を計測した結果から、どうやら引っ張られる感覚をつくり出す情報は、頭頂葉付近でコードされているということまで分かってきました。また応用の側面では、ぶるなびを使って目の不自由な方をスタジアムの座席に誘導するような試みにも参加させていただき、技術的な問題点なども洗い出すことができました。今後、さらに研究開発を発展させて、役に立つデバイスができるよう努力したいと考えています。

人間の脳の情報処理メカニズム解明により、さまざまな可能性が広がりますね。そこに向けた今後の課題は何でしょうか。

当面はMFRに関する脳内の視覚情報処理と運動指令生成までの変換過程について、さらに追究していくことが重要な課題だと考えています。最近、メタバース(仮想空間)に注目が集まっていますが、仮想空間の中でバーチャルなインタラクションをして、コミュニケーションを成立させていくということが、現実味を帯びてきました。この仮想空間におけるインタラクションを考えるうえで、脳の情報処理を理解するということはもっとも重要なポイントの1つだと考えます。ただ現在の仮想空間では、その中にいるアバター等をカーソルやマウスで動かしながらインタラクションし、映像や音声等でコミュニケーションするパターンがほとんどかと思います。今後、ヘッドマウントディスプレイ等のデバイスがかなり優秀になってくると、自分があたかもその空間にいて動いているような感覚を与えるようなことができるようになってくると思いますが、その臨場感、現実感が増大するほど、脳の情報処理のメカニズムを理解し、それをベースとしたインタフェースデバイスや安全性検討が必要になってくると思っています。

この段階までくると、デジタルツインにおいても脳内の情報処理や感覚運動系についての理解と実現が意味を持ってくるのではないかと思いますが、すぐにそのレベルまで達成するという話でもありません。人間の脳を理解してから取り掛かっていたのでは、何年あっても世に出るものにはならないほどの難易度だと思います。その意味で、脳内の情報処理メカニズムの解明されたところからパーツパーツで取り込んでいくことが重要なのだと思います。一方で私たち基礎研究者も、より現実世界における問題設定に関する脳情報処理を明らかにしていくことを加速させることが重要だと考えます。

研究は楽しくやろう

研究者として心掛けていることを教えてください。

楽しく研究をしようということを常に考えて、そのために工夫するということを常に心掛けています。仮説を出して、それはたとえ小さな仮説であっても、この実験をしたらこうなるといったことを仲間の研究者と話をするのですが、その中には対立もあります。自分の仮説が正しかったときはほっとしますが、正しくなかったときも、その理由やロジックを考えることが重要で、それを考えることを面白く感じています。そのための工夫として、比較的短期間で検証可能な仮説を立て、その仮説を検証することをある意味ゲームのように考えて楽しむようにしています。特に基礎研究の場合は短期的にビジネスにつながるようなことは少ないので、大きな仮説の下でもショートスパンで検証できる小さな仮説を立て、たとえ自分の仮説が間違いであることが実験的に明らかになっても、次の勝負に備えて作戦を立て直す(仮説のロジックの見直しをして新たな仮説を考える)ということを繰り返しながら、成果につなげていくという感じです。

また、こうしたアプローチで研究を進めていくうえで、常に世界の研究をウォッチしながら自分の立ち位置をモニタリングすることも重要だと考えます。唯我独尊の世界の中でやっているわけではないので、足元はしっかり見つめながら、対立するグループ、賛成してくれるグループの研究を見極めて自身の研究を進めていくことが重要だと思います。対立する考えが著名な研究者のものであってもそれに迎合することなく慎重に考えることが必要で、熟考していく過程で、新たな考え、アプローチ、実験方法などが出てくると思います。そして、それを別の研究グループの論文や発表と照らし合わせて見ていれば、自分の立ち位置を見失うこともないと思います。その意味で学会というのは非常に良い場所で、自分が出した結果とそれに至る考え方を発表し、それに対する参加者の反応からも得るものは大きいです。

しばらくコロナ禍で対面による学会がなくなっていましたが、最近は再開されてきており、会場にいるだけでも対面でさまざまなコミュニケーションを取ることが可能で、たとえそれが雑談であっても意外なヒントが得られることがあります。さらに、自分とは異なる分野の人たちとのコラボレーションやコミュニケーションで知識の幅が広がり、新たな方向性も見出すようなことにもつながります。私は、体性感覚から運動までの情報処理を以前から研究テーマの中心にしてきたのですが、学会に行って視覚研究者の方々の発表を見て、意見交換をすることで、新たな思考をめぐらすことができるようになり、運動野からみた視覚情報処理の研究に最近はまっています。こういった意味でも学会はすごく役に立っていると思っています。

後進の研究者へのメッセージをお願いします

とにかく研究は楽しくやりましょう。楽しむということは、楽をすることではありません。楽しむためには苦労や努力、そして楽しむための工夫が必要になります。研究を進めていくと、一見無駄に見えることへの対応をしなければならない局面もありますし、またなかなか成果が出なくて悩むこともあると思います。これを乗り越えるための苦労や努力も、考え方1つで楽しみに変えることもできます。異分野で知らないことが多すぎると、興味が持てなくて言われたことだけをやるようなことはないでしょうか。成果が出ないからと、目の前の困難ばかりを見ずに、ふと立ち止まって周りを見ることも必要ではないでしょうか。知らないことを積極的に深く知ろうとすること、分からないことをきちんと分かるようにすること、今までできないと思われていたことをできるようにすることは、とても楽しいことだと思いますので、見方を変えて楽しんで問題に取り組んでほしいと思います。こうした努力や工夫の先には、発見や新創造といった成果にたどり着ける場合もあります。その成果は世界中で自分が最初にたどり着いたものであり、これこそがまさに研究の醍醐味であり、もっとも楽しいことなのではないでしょうか。そして苦労や努力をすればするほどこの感覚は強くなるのではないでしょうか。ただし、研究を楽しくやるためには、オンとオフの区別をしっかりとできることも大切です。研究に疲れたら、しっかり休むことは重要です。もしかすると、考え抜いてもどうしても解が見つからないようなときでも、休みで遊んでいる最中にふっと良い考えが浮かぶかもしれません。そんな経験が私もあります。

それから、他の人とのコラボレーションをすることも大切です。特に最近の研究は、すべて1人で完結することはまず不可能で、だからこそ他の研究者とコミュニケーションをとってコラボレーションすることが必要です。コラボレーションする相手は、自分と少し視点が違う人や、専門が違う人が良いかもしれません。対立するような議論も研究の質を高めていくためには重要です。賛同してくれる人だけで徒党を組んでいるのはよくありません。知らないことを知るというのは面白く、楽しいという感受性を持って話をすれば、自分の研究の幅を広げることができるとともに、楽しく研究や議論をすることもできると思います。

■参考文献

(1) N. Abekawa, K. Doya, and H. Gomi: “Body and visual instabilities functionally modulate implicit reaching corrections,” iScience, Vol.26, No.1, 105751, Jan. 2023.

(2) D. Nakamura and H. Gomi: “Decoding self-motion from visual image sequence predicts distinctive features of reflexive motor responses to visual motion,” Neural Networks, Vol.162, pp.516-530, May 2023.