2021年10月号

特別企画

セーリング競技 × 超高臨場感通信技術 Kirari!

- 5G

- Kirari!

- ライブビューイング

NTTは、東京2020 組織委員会がオリンピック・パラリンピック期間中に実施した5G(第5世代移動通信システム)を活用した新たなスポーツ観戦体験を提供するプロジェクト「TOKYO 2020 5G PROJECT」において、超高臨場感通信技術 Kirari!の技術提供を行いました。本稿では、江の島ヨットハーバーで行われたセーリング競技において、レース会場間近で撮影した超ワイド映像を江の島の観客席へ伝送することで、あたかもレースのすぐ近くで観戦しているかのような臨場感を提供する新しいスポーツ観戦体験について紹介します。

宮武 隆(みやたけ たかし) /清水 健太郎(しみず けんたろう)

早坂 知行(はやさか ともゆき)/青木 政勝(あおき まさかつ)

千明 裕(ちぎら ひろし)/中嶋 淳一(なかじま じゅんいち)

浦田 昌和(うらた まさかず)/小合 健太(おごう けんた)

吉田 由紀(よしだ ゆき) /木下 真吾(きのした しんご)

NTT人間情報研究所

プロジェクトの概要

セーリング競技では、レースが陸から離れた沖で行われるため、観客は防波堤から双眼鏡を使って観戦する必要がありました。今回、東京2020オリンピック・パラリンピック競技大会のセーリング競技にて、通信技術を活用することによってこの問題を解決し、あたかもクルーズ船の特等席からレースを観戦しているかのようなリアルを超える革新的な観戦スタイルの創造にチャレンジしました。具体的には、水平解像度12Kに及ぶ超ワイドなレース映像を、5G(第5世代移動通信システム)と超高臨場感通信技術 Kirari!を用いて、観客席近くの長さ55 mの洋上ワイドビジョンにライブ中継しました(図1)。

今回の取り組み概要は以下のとおりです。

・期間:2021年7月25日~8月4日

・場所:江の島ヨットハーバー

・実施種目:10種目

・体験者:延べ約4000名(無観客開催につき、選手や関係者のみ観覧)

・体制:東京2020オリンピック・パラリンピック競技大会組織委員会イノベーション推進室、NTT、NTTドコモ、インテル株式会社の4社で結成した「TOKYO 2020 5G PROJECT」にて実施。NTTは技術主管として、本プロジェクトに参画(図2)。

また、超ワイド映像は、メインプレスセンターが設置されている東京ビッグサイトへもライブ中継し、国内での移動など行動制限を課せられているメディア関係者へも現場の臨場感を伝えました(図3)。

今回、オリンピックセーリング競技は無観客開催となりましたが、選手へ遠隔にいる家族や知人の応援を届ける「バーチャルスタンド」施策も実施しました(図4)。

システム構成

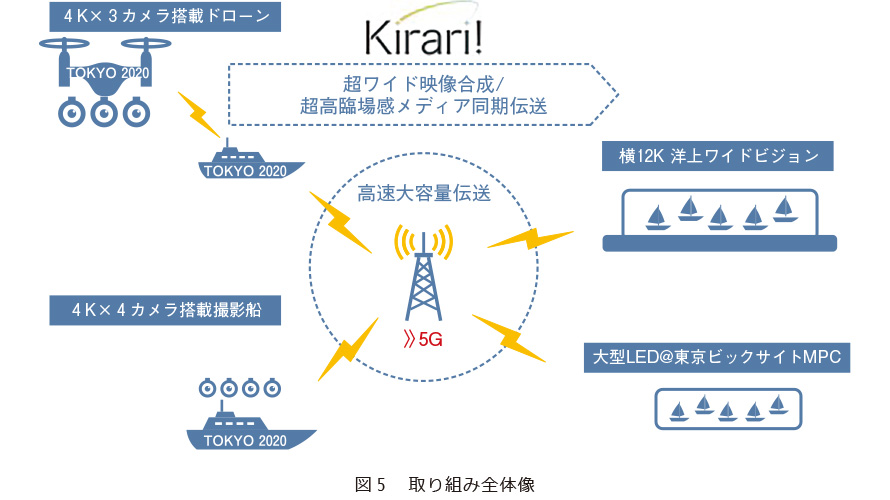

本取り組みの全体像を図5に示します。まず、複数台の4Kカメラを搭載した船やドローンから撮影を行います。撮影した映像は、超高臨場感通信技術 Kirari!と高速大容量伝送が可能な5Gを用いて、横12K解像度の超ワイド映像としてリアルタイムに合成し、伝送します。伝送された映像は、セーリング競技観戦場所前の洋上に浮かべた長さ55 mの洋上ワイドビジョンと東京ビッグサイトのメインプレスセンターに設置された横幅13 mのLEDにリアルタイムで表示されます。

技術

■超高臨場感通信技術 Kirari!

Kirari!は、観戦者が競技会場から離れた場所にいても、あたかも競技場にいるかのような観戦体験を実現するための通信技術です。本プロジェクトではKirari!の技術要素の中で、超ワイド映像合成技術と超高臨場感メディア同期技術を使った映像伝送を実施しました。

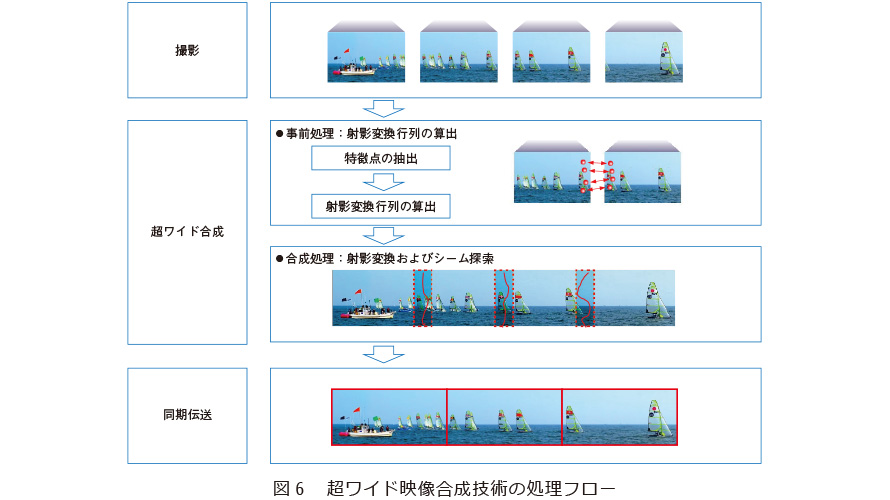

(1) 超ワイド映像合成技術

超ワイド映像合成の処理フローを図6に示します。まず、できるだけ各カメラの光軸を合わせ、隣り合う映像間で撮影範囲が20~40%程度重複するようにカメラを設置した状態で映像を撮影します。実際の合成処理を行う前に、事前処理として、各カメラの視差を補正するために、基準となる静止画を用いて、抽出した特徴点から射影変換行列を算出します。セーリングの場合は、レース直前に待機している競技艇などを撮影して基準画像としました。これを実現するため、基準画像取得から、ワイド合成パラメータの決定までの一連の流れを、今までより効率化(画像を圧縮し、伝送時間を短縮するなど)しました(従来の時間の3分の1ほどに短縮)。次に合成処理時は、各映像フレームに対して、算出した射影変換行列を使って視差の補正を行いつつ適切な映像の結合線(シーム線)を見つけること(本処理をシーム探索)で、映像フレームを合成します。合成処理においては、「同期分散処理」「シーム探索の高速化」「GPU(Graphics Processing Unit)活用」の3点を特徴としています。

同期分散処理では、リアルタイムに膨大な映像処理を実行するため、入力・出力条件により合成処理を複数サーバに分散します。この際、各サーバにおいて合成タイミングを同期させるために、入力時に映像フレームに対して同じタイムスタンプを付与し、このタイムコードを後段のエンコーダ等の伝送装置に伝搬させることで、システム全体で同期制御を可能としています。なお、タイムスタンプは、撮影装置等で付与され入力映像に重畳されたタイムコードを利用する方法と、映像が入力された際にタイムコードを生成する方法の2つから選択することができます。

シーム探索の高速化では、シーム探索時に映像フレームを解析して得られる動物体の動きや形を用いることに加え、過去の映像フレームのシーム位置を用いることによりシーム位置のバタつきを防止します。この際、過去の映像フレームのシーム探索が終わってから次のフレームのシーム探索を行う方法ではリアルタイム合成を実現することが難しくなります。そのため、事前探索として縮小した映像フレームに対してシーム探索を行い、その事前探索結果を次のフレームにおけるシーム探索で利用する2段階シーム探索を行うことにより、リアルタイム合成を可能としています。

GPU 活用による高速化では、ほぼすべての映像処理をGPU 上で実行することにより、処理の集約化・高速化を達成しています。具体的には、GPUを利用することにより、SDI ボードから入力された映像を最小限のGPU コストでGPU に転送し、その後の映像処理をGPU で実行します。その結果、例えば、4 台の4K カメラからの映像より12K(4K × 3)の超ワイド映像を合成する場合、GPU を使わない場合に比べて必要となるサーバ台数を3分の1(6台→ 2 台)に削減することができました。

(2) 超高臨場感メディア同期技術(Advanced MMT)

超ワイド映像合成技術によって生成された映像は、一般的な表示機器、エンコーダ・デコーダで扱うことができるように、複数の4K 映像に分割して伝送を行います。今回は横12K、縦1Kの映像のため、3つの4K映像に分割しました。Kirari!では、分割されて伝送される個々の映像・音声の再生タイミングを完全に同期させる手段として、超高臨場感メディア同期技術(Advanced MMT)を用います。超高臨場感メディア同期技術(Advanced MMT)は、メディア伝送規格MMT(MPEG Media Transport)に準拠したUTC(Coordinated Universal Time)ベースの同期制御信号の活用によって、複数映像・音声を低遅延に同期伝送する技術です。本技術により、ワイド映像だけでなく、特定選手を追跡するような複数アングルのカメラ映像(2K等)を同期して表示することや、各カメラ映像・音声が伝送されるネットワーク(専用線やインターネット、無線LAN等)や端末処理による遅延の違いを吸収することが可能となり、複数の映像・音声が完全同期した超高臨場感な視聴体験を実現できます。

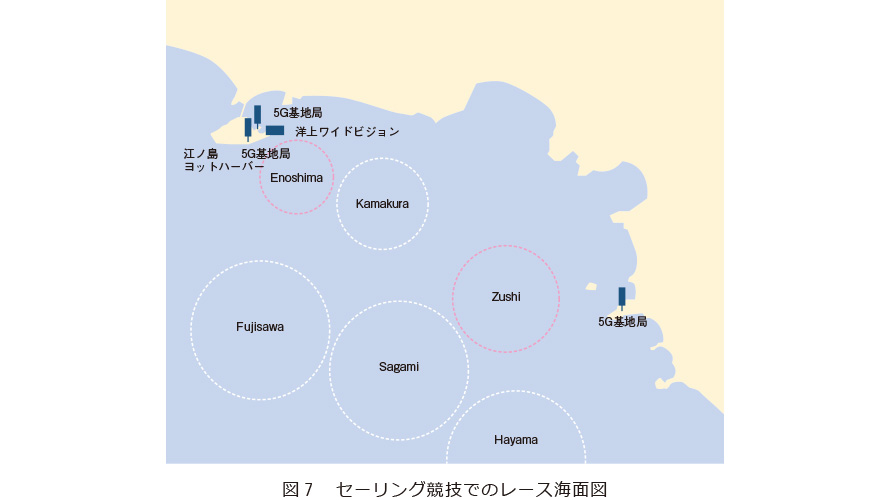

■無線通信技術

東京2020オリンピック・パラリンピック競技大会でのセーリング競技は、6つの海面でレースが実施されました(図7)。本プロジェクトでは、Enoshima海面とZushi海面の2海面を実験海面としました。Enoshima海面では、撮影船からの超ワイド映像の撮影を、Zushi海面では撮影船に加えドローンを用いた超ワイド映像の撮影を行いました。両海面近くには、図中の位置に5Gの基地局が設置されました。

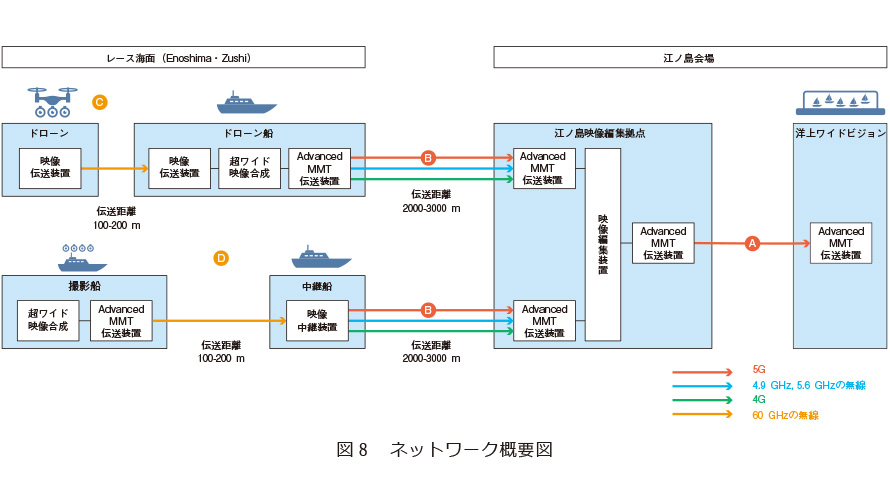

本プロジェクトで用いたネットワークの構成を図8に示します。船から陸に向けての映像のアップリンク、および映像編集拠点からバージ船のLEDへのダウンリンクなど、NTTドコモの5G回線を軸に、通信帯域、距離、指向性など特性が異なる複数の無線通信も活用しました。またドローンの飛行コントロール、バックアップ映像や船上に配置されたサーバの制御などには、NTTドコモの4G回線を用いました。

(1) 5Gのダウンリンク伝送

映像編集拠点からバージ船LED間の映像伝送は、NTTドコモの5Gアクセスプレミアムサービスにて映像伝送を実施しました。受信端末は市販のCPE端末を利用しました。大会期間中200 Mbit/sの映像伝送を8時間以上連続運転し、安定した映像伝送を実施しました。

(2) 5Gのアップリンク伝送

ドローン映像の伝送を中心にNTTドコモの5Gアクセスプレミアムサービスを利用しました。受信端末は市販のCPE端末を利用しました。平均80 Mbit/sの帯域にて、2K映像×6本の映像を伝送しました。さらにバックアップ用に、NTTドコモの4Gサービスを利用し、5隻の船やドローンから、トータル50 Mbit/sの映像伝送を実現しました。

(3) ドローンからの映像伝送

今回撮影を実施したドローンの構成を図9に示します。1台のドローンに4Kカメラを3台搭載しました。ドローンで撮影した4K映像3ストリームを、ドローンの離発着を行うドローン船に向けて60 GHzの無線を用い、映像を伝送しました。その際3本の映像ストリームに対して、時間同期を行い伝送しました。ドローン船上ではワイド合成を実施し、5GアクセスプレミアムとAdvanced MMTにより、江の島の映像編集拠点まで同期伝送を実施しました(図8)。

ドローンとドローン船間の映像伝送には、NTTアクセスサービスシステム研究所が開発した技術により、60GHzによる無線通信を実現しました。利用した無線機器は、常時アンテナ面を向け続ける必要があるため、より安定した無線通信を実現するため、アンテナの方向をRTK(Real Time Kinematic)のGPS情報を用いて自動制御し、ドローン方向に常にアンテナを向ける技術も開発しました。またドローンの撮影角度によっては、機体自身が無線通信の死角となることがあり、電波強度に基づきアンテナを自動切替する技術を開発しました。これら技術により、ドローンの撮影に自由度を与えながら、ドローンとドローン船間の安定的な映像伝送を実現しました。

またドローンのセキュリティ対策として、ドローンの飛行コントロールは4Gと2.4 GHzの2つの無線を利用し、2重化を行いました。

(4) 撮影船からの映像伝送

撮影船からの映像伝送については下記要件がありました。

① レース海面が、天候や風向きによって、直前に変更となることもあるため、撮影船は、柔軟に移動できるようにする必要がある。

② レース海面によっては、2〜3 km無線伝送を行う必要がある。

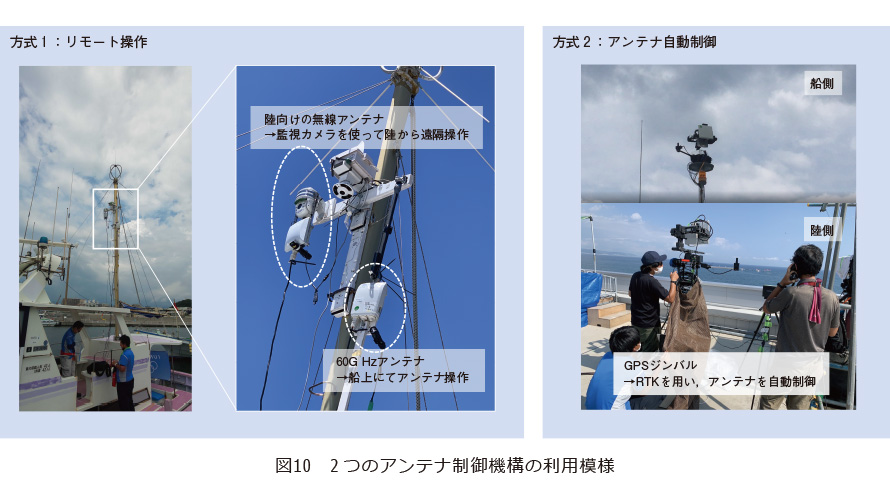

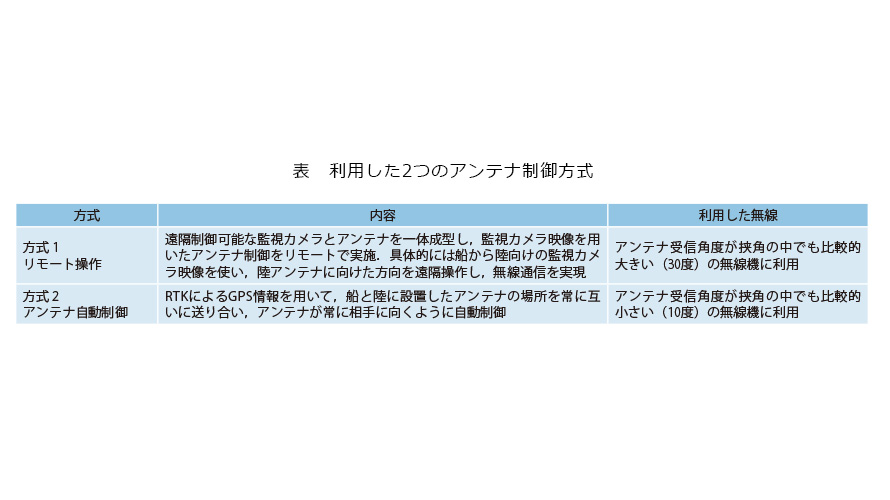

これらを実現するため、撮影船とは別に、陸まで長距離無線伝送を行う中継船を用意しました。撮影船と中継船間の映像伝送には、伝送距離は短いが大容量伝送が可能な60 GHzの無線を使いました。撮影船が柔軟に移動できるように、アンテナの指向性は比較的広角な無線を選定しました。中継船から陸に向けての映像伝送は、5Gに加え、4.9 GHz、5.6 GHzの無線通信も補助として利用しました(図8)。これらの無線通信は、長距離伝送が可能である反面、アンテナ指向性が強くなるため、常に送受信機のアンテナ面を合わせる必要があります。今回、2つのアンテナ制御機構を開発しました(表、図10)。

船の選定にも工夫を行いました。撮影船は競技近くでの撮影を実施したいため、競技艇の航行に影響を与えない小型漁船を選定しました。中継船には数キロの無線伝送を行うため、海上でも揺れをおさえることが可能な大型漁船を選定しました。

陸側のアンテナについても海岸線かつ高い建物の屋上が確保できない場合がありました。その際、車両から高さを確保できるポールを持つ車両を確保、頂上にアンテナを設置することで、アンテナの見通しを確保しました。

60 GHz帯は、100 mの距離(船どうしの距離)で、100〜200 Mbit/sの通信速度を実現し、4.9 GHz帯や5.6 GHz帯は、2〜3 km(船―陸間)の距離で、50〜150 Mbit/sの通信速度を実現しました。通信速度は、波の状況に大きく依存しました。特に、台風8号接近中は波が高くなり、無線通信機のアンテナ制御が難しく、大きく通信速度が低下しました。

■洋上ワイドビジョン

あたかもレースのすぐ近くで観戦しているかのような臨場感を創り出すためには、①臨場感の高い映像と、②その映像を活かす空間が必要となります。

①に関して、リアルサイズの競技艇の映像、視野を覆い尽くすディスプレイのサイズ、高い解像度、ドットが目立たないディスプレイが必要です。今回、実装した洋上ワイドビジョンは、高さ5 m、 幅55 m、水平解像度12K、 垂直解像度1Kの仕様であり、ピッチサイズは4.8 mmですが、図11のように観客席から40 m離れた場所に設置し、ほぼ網膜解像度を超えているため、映像の荒さは目立ちません。また、②を実現するために、ディスプレイを配置する空間も重要となります。ディスプレイは、四角い切り取られたディスプレイであるため、どうしてもテレビのような不自然な感覚が残ってしまいます。これを洋上に浮かべ、ディスプレイの境界を自然の空や海と融合させることで、自然な臨場感を創り出すことができます。

洋上ワイドビジョンを設置するにあたり、LEDを設計構築する専門メンバーだけでなく、海上の揺れを踏まえた構造計算を実施する専門メンバー、船を航行、係留する専門メンバー、海事代理士、気象予報士などで体制を組み、大会本番での気象を考慮した検討を実施しました。

具体的には過去10年間の江の島の7~8月の気象データを収集し、風速・風向・波高などを把握し、設計したLEDの強度、および係留時の固定方法の安全性を評価して、ワイドビジョンの避難基準を定めました。避難基準としては、風速25 m以上、波高1.6 mを超えてさらに高くなる場合を条件とした運用を行いました。この条件は上記のLEDの強度や係留時の船の固定強度での判断のみならず、江の島からお台場へ避時する際の江の島、およびお台場へ戻る途中の三浦半島の海上の気象も専門メンバーと熟慮を重ね決定しました。大会時に発生した台風8号についても、気象情報を常に把握、上記基準に基づき避難実施判断を行いました。結果として、避難不要と判断し、事故なく運用を実施することができました。

■波の揺れ補正技術

船での撮影は海上での撮影となるため、波の揺れにより映像に揺れが発生します。この揺れに対して、リアルタイムで波の揺れを補正する技術を開発しました。具体的にはオプティカルフローを用い、映像の揺れ方向を検出し、リアルタイムで補正を行い、揺れをできるだけ抑える技術を開発しました。

結果

大会期間中、大きなトラブルなく、映像中継を実施しました。無観客開催でしたが、選手や関係者を中心に毎日数100人程度の方に体験していただきました。多くの方から、「これまでに体験したことがない高い臨場感に驚いた」「一般の方にも是非見てもらいたかった」「レースの状況が非常に分かりやすくなった」「こうした観戦スタイルが一般的になれば、セーリングファンも一気に増えるのに」など、驚きや感動、今後への期待の声が多数寄せられました。特に、私たちがめざしていた、「あたかもそこでレースが行われているような臨場感」については、海に浮かぶ洋上ワイドビジョンに表示された迫力あるリアルサイズの競技映像が、実際の海面や空などリアルな空間と融合されることによって、まさに「レース空間そのものがワープしてきた」体験を創り出せたように思います。

技術的には、5G含め無線通信が安定しない場面もあったこと、船やドローンからの撮影では、波やエンジンの振動を完全に吸収できず、映像が乱れたことなど、課題はまだありましたが、オリンピックという非常に高いレベルが要求される環境で素晴らしい実績を残せたと思います。

まとめ

商用5Gと研究所が開発した超高臨場感通信技術 Kirari!を用い、超ワイド映像の中継を実施しました。横解像度12Kの超ワイド映像は、江ノ島会場に浮かぶ55 mの洋上ワイドビジョンと東京ビッグサイトのメインプレスセンターにて表示され、選手や関係者、海外のメディアの方が体験され高い評価をいただきました。本プロジェクトで使用した通信技術を用いれば、同じ競技会場内にとまらず、海外も含めた遠隔へのライブビューイングも可能となります。コロナ禍において、NTTがめざすリモートワールドの実現に向けてのショーケースと位置付けることができます。今後は5G、さらにはIOWN(Innovative Optical and Wireless Network)のオールフォトニクス・ネットワークをインフラとして、スポーツやエンタテインメント分野を中心に、さらなる通信技術の研究開発を進めていきます。

謝辞

プロジェクトを実施するにあたり、一緒に検討を進めていただいた5G PROJECTメンバーである東京オリンピック・パラリンピック競技大会組織委員会イノベーション推進室、インテル株式会社の皆様に感謝します。また本施策を実施するにあたり多大なる協力をいただいた東京オリンピック・パラリンピック競技大会組織委員会各FAの皆様、ワールドセーリング様、および日本セーリング連盟様、撮影に必要な船を提供いただいた片瀬江ノ島漁協、腰越漁協、小坪漁協の皆様に感謝します。