2025年1月号

from NTTファシリティーズ

カーボンニュートラルに貢献する「次世代型データセンタ」プロジェクト

生成AI(人工知能)の登場によりデータセンタの構築需要が急拡大する中で、サーバの高発熱化に伴いデータセンタの消費電力量が著しく増加し続ける一方、データセンタのカーボンニュートラル化は世の中の重要命題となっており、この相反する目標をいかに同時実現できるかが喫緊の課題となっています。NTTファシリティーズではこの課題解決に向けて、全面的に液冷方式サーバを採用した次世代型データセンタ構想プロジェクトを開始しました。

本プロジェクトの概要

ICTサービスを支えるデジタルインフラとしての機能を担うデータセンタは、生成AI(人工知能)の普及などによって今後需要がさらに拡大するといわれています。サーバのプロセッサにおける計算処理能力の向上に伴いサーバの発熱も著しく増大していますが、今までのような空気を媒体とした空冷空調機だけではその発熱を冷却しきれなくなり、液冷方式に対応するサーバが近年急スピードで開発されています。本プロジェクトでは、平均発熱量40kW(サーバはNVIDIA DGX H100のモデル)をベースとした液冷方式のサーバをベースに2023年秋ごろから検討しています。

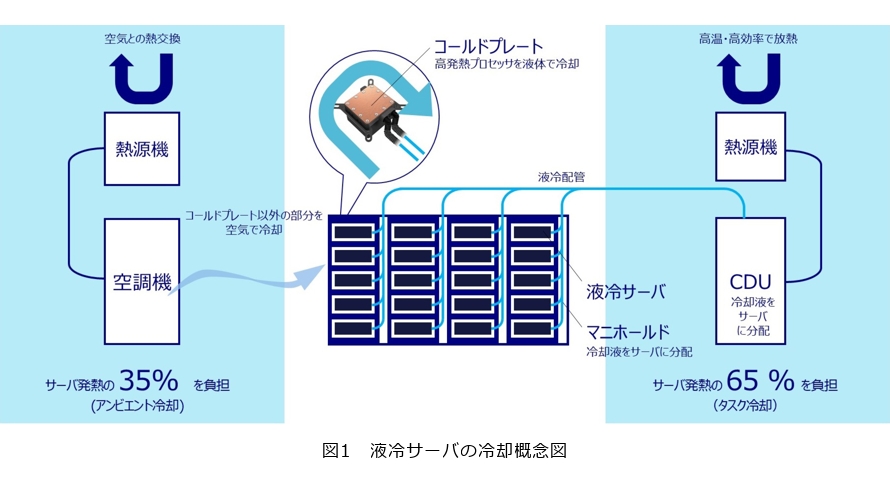

液冷方式は、接触タイプ(コールドプレート冷却)と浸漬タイプ(液浸冷却)に大別されますが、本モデルでは接触タイプを対象としています。接触タイプはCDU(Cooling Distribution Unit)*1から冷却液をサーバ内のコールドプレートに送り込むことにより、サーバを液体で直接冷やす方式です(図1)。今回の検証では、サーバの発熱量の約65%を液冷方式で冷却することができ、データセンタ全体の消費電力量の約20%を占めるサーバ冷却用消費電力を約50%削減することが可能になると試算しています。

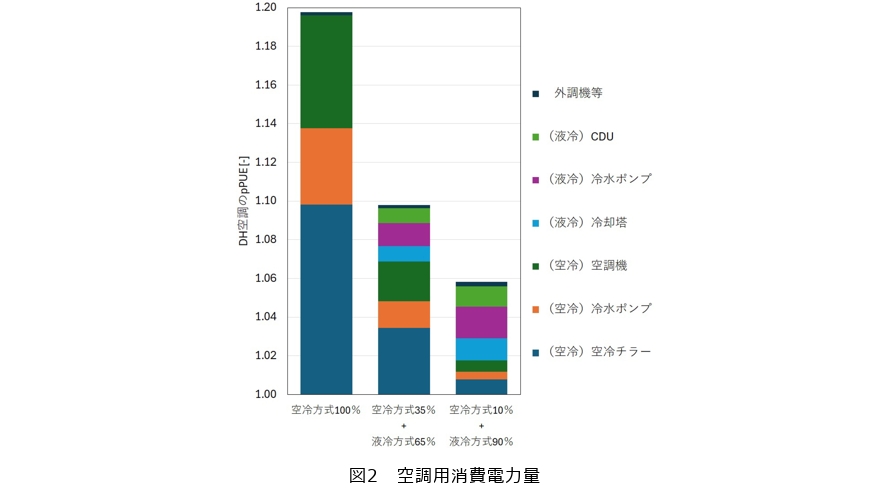

一般的に設計pPUE(partial Power Usage Effectiveness)*2は空冷方式で1.20、液冷方式で1.10程度となります(図2)が、この消費電力量効果は液冷方式の割合に比例します。さらに液冷比率を高く想定し、仮にサーバの発熱量の約90%を液冷方式で10%を空冷方式で冷却した場合のpPUEは1.06となります。

液冷サーバの設置による空調エネルギー削減の可能性を3つに大別し、空冷方式との数値比較をしながら、それぞれのメカニズムを解説します。

*1 CDU:液冷方式のサーバへ要求される温度の液体を送り込むための機器。

*2 pPUE:パーシャルPUE。対象設備の総消費電力量をサーバ消費電力量で除したもの。本稿では、DH空調に関する空調設備を対象としました。

■空調用冷水温度の上昇

一般的に、大型の空冷空調機ではチラー等の熱源機器により生成された水が冷却に使用されますが、データセンタの空調用冷水生成のためには圧縮機を用いた熱源機器(圧縮機熱源)が必要です。これは標準的な空冷空調機への送水温度(給気15~25℃、還気25~35℃程度)に対し、日本における年最高外気温度(35~40℃DB、25~30℃WB)が高温多湿であり、建物外へ熱を搬送するために圧縮機が必要となるためです。これまで省エネルギー促進の観点から、中間季や冬季など部分的に熱源を停止する外気冷房システム(フリークーリングシステム)が多く提案・採用されてきましたが、最暑期のために圧縮機熱源を設置する必要がありました。液冷方式では、CDUへ送る空調用冷水温度は空冷方式のそれより高い温度帯となる可能性があります。これは“空気よりも熱が伝わりやすい”という液体の特性により、高温度帯でプロセッサとの熱交換が可能となったことによります。当該建物ではCDUへの送水温度を32℃と設定し、潜熱冷却を利用した冷却塔を採用することで、圧縮機熱源を一切採用しない構成としました。本検討条件では、冷却塔の冷水生成効率は圧縮機熱源の約7倍と大きくなります。従来の空冷方式では、データホールの空調用年間消費電力量のうち、圧縮機熱源が占める比率は約5割と大きく、当該システムの省エネルギー効果の内訳として1番大きい要素となっています。さらに、圧縮機熱源は高外気温時に消費電力が増加する傾向があるため、他機器と比較してピーク電力に与える影響が大きくなりますが、圧縮機熱源の削減は電気設備容量をコンパクト化するうえでも有利に働くといえます。

■送水温度差の拡大

液冷方式では、サーバの高集積・高密度化により、排熱温度帯がさらに高くなる可能性があるため、大温度差での冷水供給による省エネルギーの可能性があるといえます。空冷方式では、冷水送水温度と還水温度の差(送水温度差)は従来10℃前後が主流でしたが、当該モデルでは15℃として設定しました。一定量の熱量を搬送する前提では、送水温度差と流量は反比例の関係となります。従来の空冷方式を例にとると、熱源と空調機間の冷水の搬送動力は、データホールの空調用年間消費電力量の約2割を占めます。液冷方式により送水温度差が大きくなることは、空調用冷水の搬送動力が削減されることにつながります。

■空気から液体への熱媒の変更

従来の空冷方式では、大量の空気を吹き出して冷却を行うため、空冷空調機の送風機動力はデータホールの空調用年間消費電力量の約3割を占めます。液体は空気と比較して比熱が大きく熱搬送効率に優れることから、空気の代わりに液体で熱を搬送する液冷方式は省エネルギー性能に優れています。本検討条件では、液冷方式は空冷空調機と比較してサーバからデータホール内の空調機器までの熱搬送エネルギー効率は約5倍に向上しています。

周辺環境に調和するデザイン

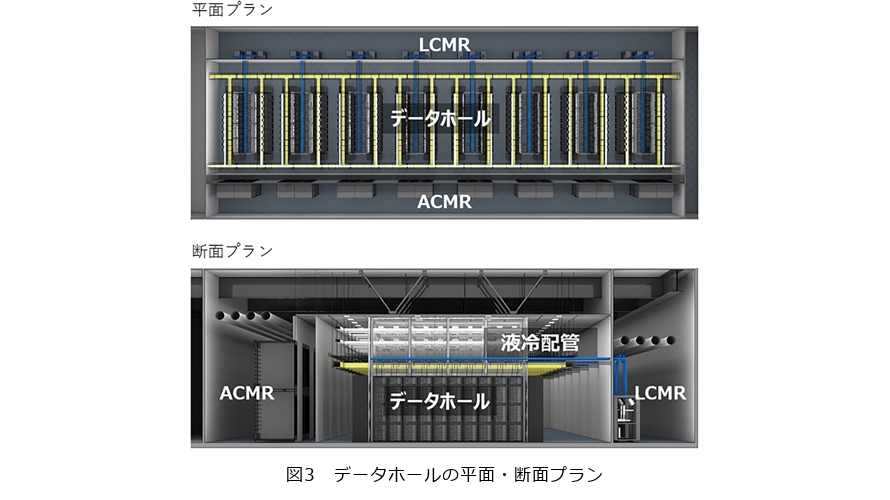

本プロジェクトのモデルプランは、新築だけでなく既存の空冷データセンタの一部または全部を液冷方式に改修するというニーズにも対応するため、従来の空冷データセンタのオーソドックスな平面・断面形を踏襲していますが、液冷方式対応の特徴としてCDU専用のLCMR(Liquid Cooling Machine Room)*3スペースを設けることにより、セキュリティ性・メンテナンス性・拡張性を確保しています(図3)。

サーバの高集積・高密度化により、新たにLCMRを設けたとしても、サーバを設置するデータホール面積が従来の3分の1程度に縮小されると想定され、それに伴い建物全体のボリュームも縮小化されると見込んでいます。これにより敷地に余裕が生まれるため、データセンタを運用する事業者にとっても敷地利活用の選択肢が増えることになります。その選択肢は、敷地そのものを縮小化する、受電が確保できればデータセンタの規模を大きくする、データセンタに付随する用途(オフィスや研究所など)の建物を増築するなどが考えられますが、私たちはそのスペースを周辺地域への貢献に活用できないかと考えています。セキュリティ性が高く、さらに年々大規模化していくデータセンタは、その特性上閉鎖的で圧迫感のある建物になりやすく、また空調や発電機などの騒音・廃熱への対処という設備的な諸課題もある中で、特に国内ではデータセンタが住宅地近傍に建設されるケースも多く、地域や周辺環境との調和が重要なテーマとなっています。本プロジェクトではデータセンタの液冷化により生まれた余剰スペースの利活用方法として、地域に開放した緑のオープンスペースによる良好な景観形成とヒートアイランドの抑制に寄与する水盤を設け、物理的なセキュリティを確保しながら周辺環境への調和を意識したデザインを構想しました(図4)。

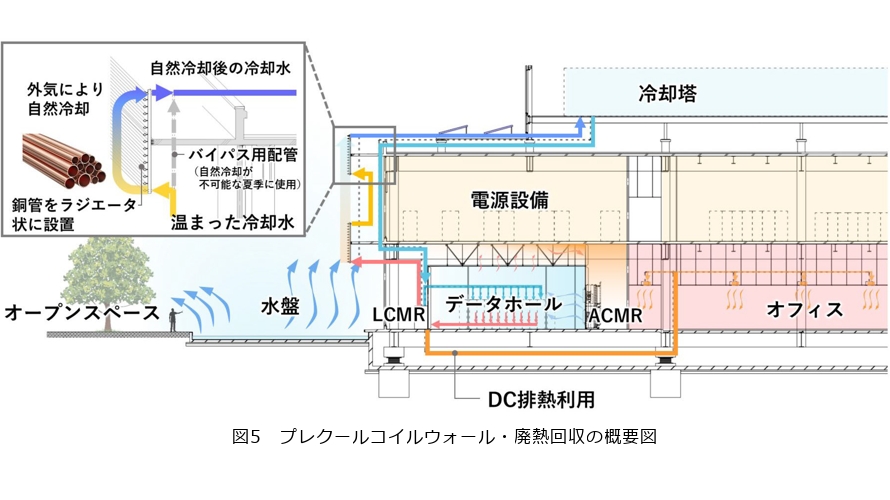

また、今回考案したプレクールコイルウォール™*4は、空調機のラジエータを露出したような設備・外装システムです。サーバの冷却に使用され温まった冷却液を建物外周に張り巡らせた熱伝達率の高い銅管内に通すことにより、季節や方位によっては屋上の冷却塔を介すことなく外気のみによる自然冷却を行うことができると考えています(図5)。

*3 LCMR:液冷用CDUの専用スペース。

*4 「プレクールコイルウォール™」は商標登録出願中です。

データセンタにおけるファシリティ要件の変化

一方、先日リリースされたNVIDIA DGX GB200(NVL72)は1ラック当りの発熱は120 kWといわれており、上記で検討したモデルの実に3倍もの発熱量のサーバが登場しました。生成AIサービスの拡大に伴い、データセンタに求める要件も変化してきています。学習用AIは立地要件が緩和されるため地方に大規模化なデータセンタを構築する方向へ向かっており、推論用AIは従前のクラウドサービス用データセンタと同等の立地要件が求められる傾向にあるため、土地や電力の確保競争がますます激化するとともに、既存のデータセンタの活用も増えていくと予測されます。この2つの大きな方向性のいずれも、高密度化された高発熱のサーバへの対応が必須となる状況で、データセンタのファシリティ要件にも変化が予想されます。

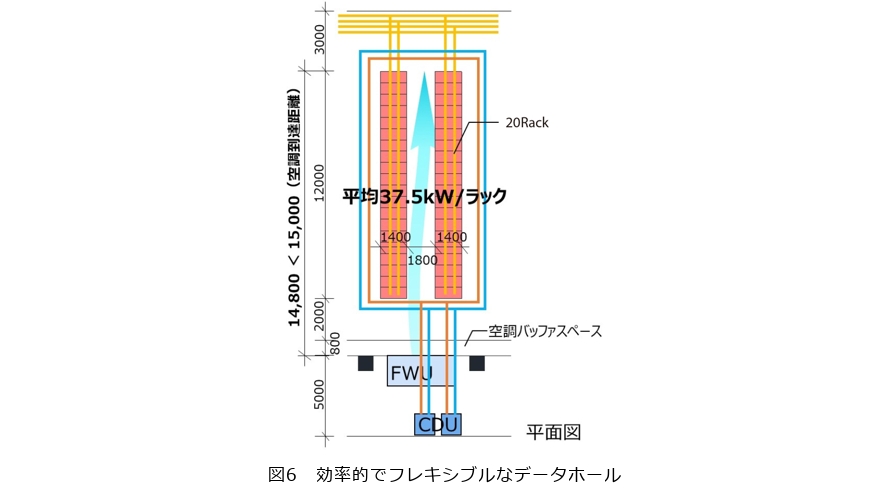

データホール内のサーバラック上部までは分岐バスダクトにより配電しますが、現時点におけるバスダクトの既製品最大電流が1200A程度のため、架列(Row)当り850kW程度(1200A×415V×√3)が上限となります。また、UPS(Uninterruptible Power Supply)からの電源供給量の観点で考えると、4 to make 3の冗長方式*5の場合6架列で1モジュールを構成するのがもっとも効率的です。現時点におけるUPSの既製品最大級単機容量が1500kVA程度であるため、1モジュール当り4.5MW(1500kVA×3台)、1Row当り750kW(4.5MW/6Row)の電源供給容量となります。このことから、1 Row当りの消費電力は750kWが上限値と設定できます。NVIDIA DGX GB200(NVL72)の場合、液冷:空冷=9:1といわれていますので、この比率を用いるとCDUの冷却能力は675 kW/Rowとなります。一方、空調設備の観点で考えると、一般的な空調効率の良いFWU(ファンウォールユニット)の冷却能力は100kW/mであり、1Row当りの空冷能力は約300kW(1Row幅≒3m)となるため、1Row当りの消費電力:750kWに対する冷却能力は、空冷:300kW(40%)、液冷:675kW(90%)となります。1Row当り100%以上の冷却能力を供給できる設備スペースを用意することで、さまざまなタイプのサーバを組み合わせて設置することや、将来の新規サーバ開発へのフレキシビリティを確保しておくことなどにもつながります。また計算上は120kW/ラックのサーバは最小6ラックで架列を構成可能となりますが、そこに低発熱ラックが設置されてしまうと、バスダクト、FWU、CDUの設備容量に対して設備過剰の状況になります。いつ、どのタイプのサーバを、どの程度設置するのかが不確定な状況下においては、空冷到達距離上限の15m程度を架列長さ(20ラック/Row)の上限としてデータホールのスペースを確保(結果としてサーバの平均発熱量が37.5kW/ラックとなる)する条件で設計をしていくと、現時点におけるAI専用データセンタの効率的でフレキシブルなデータホールの大きさや形状が実現できると考えられます(図6)。

*5 バスダクト4系統(A~D)で各架列2系統ずつ供給する(AB、AC・・・CD)と6パターンの組合せとなり、1つの系統が遮断されても3つの系統の負荷が均等となる仕組み。

さまざまなデータセンタ冷却システムの検証

当社は設計事務所でありながら、CDUをはじめとするデータセンタ専用の海外製大型空調機器の調達・保守にも対応しており、設計監理の領域にとどまらず、設計・工事・物品調達・保守運用*6等のデータセンタ構築のあらゆる分野でプロジェクトにかかわることができる総合エンジニアリング力を擁しています。2025年4月、NTT武蔵野研究開発センタ内の一部に「Products Engineering Hub for Data Center Cooling(仮称)」を構築する予定で、当社が提供する空調関連商材(STULZ社製空調機・CDU、SMARDT社製チラー、Evapco社製ハイブリッドドライクーラー等)のさまざまな実機検証を行う機能、お客さまとともに確認可能なショールーム機能、当社の構築・保守技術者の育成機能を担う総合的な検証施設です。この検証施設の屋上の一角にプレクールコイルウォールのモックアップをつくり、その具体的な効果を検証する予定です。プレクールコイルウォールの素材についても、銅管は高価な素材であるため、廉価な素材も含めた比較検討や、熱交換を効率的に行うために銅管部分の表面積を大きくするためのフィンの設置方法などのディテールなども合わせて検証しています。

*6 当社が扱う空調関連商材以外のデータセンタの保守業務はNTTアノードエナジーにより行います。

現状の課題と今後の展開

大規模化したデータセンタが生み出す熱量は膨大であり、プレクールコイルウォールによる自然冷却だけでなく、生み出された熱を有効活用するデータセンタ廃熱利用システムも合わせて考えていく必要があります。データセンタ内共用部の給湯・暖房への活用だけでなく、周辺施設との連携によって街づくりに貢献できる仕組みも考えていく必要があるでしょう。

海外では、圧倒的な敷地規模の大きさや周辺環境・建築法令上の条件の違いもありますが、液冷方式のデータセンタはスピード感をもって実現され始めています。この分野における再生可能エネルギー連携などの取り組みも海外のほうが進んでいますが、例えば北欧では水素や風力等の再生可能エネルギー電源比率が高く、廃熱利用も含めてインフラレベルで整備されています。日本でも、電力供給や地政学上の安定性とともに、主要都市からのアクセス性、地震や台風・水害等の自然災害と向き合ってきた高い技術力を踏まえて、データセンタの建設需要は今後も伸びていくといわれています。

今後データセンタが全国各地に構築できる可能性が増えていく中で、いかに消費電力を抑えながら地域に調和できるかという議論は、近年あまりなされてきませんでしたが、これからはIT業界と建築業界で連携しながら議論を深めていく必要があるでしょう。高発熱サーバ対応と省エネルギー・カーボンニュートラルの同時実現に加えて、周辺環境と調和し地域に愛されるデータセンタの実現に向けて検証を進めつつ、さらに一歩先のデータセンタの未来についても引き続き構想していきたいと思います。