2025年8月号

特集1

IOWN×空間伝送──離れた空間が1つになるコミュニケーション体験

- IOWN

- 空間データ伝送

- 大阪・関西万博

本稿では、2025年日本国際博覧会(大阪・関西万博)のNTTパビリオンで展示されている、音楽ユニット、PerfumeのパフォーマンスをIOWN(Innovative Optical and Wireless Network)でリアルタイムに伝送した取り組みと技術内容について紹介します。本取り組みでは、吹田市の万博記念公園と夢洲のNTTパビリオンをIOWNでつなぎ、NTTで研究開発している動的3D空間伝送再現技術と触覚振動音場提示技術によって、離れた場所でパフォーマンスをしているPerfumeが目の前に現れるような体験を実現しています。

松元 崇裕(まつもと たかひろ)/千明 裕(ちぎら ひろし)

村崎 和彦(むらさき かずひこ)/望月 崇由(もちづき たかよし)

谷田 隆一(たにだ りゅういち)/島村 潤(しまむら じゅん)

NTT人間情報研究所

背景とねらい

現在開催している2025年日本国際博覧会(大阪・関西万博)は、前回の日本万国博覧会(大阪万博)で「未来の電話」としてワイヤレステレフォンを発表してから、ちょうど55年後にあたります。NTT研究所では、これからの未来社会は映像と音声による2Dコミュニケーションを超えて、離れた場所の3D空間全体をIOWN(Innovative Optical and Wireless Network)による低遅延で共有し、さらに視覚・聴覚にとどまらず人間の五感すべてがつながるコミュニケーションが当たり前になると考え、その実現をめざしています。

大阪・関西万博では、そのような未来のコミュニケーションを体現する取り組みとして、夢洲のNTTパビリオンと吹田市の万博記念公園をIOWNでつなぎ、音楽ユニット、Perfumeのライブパフォーマンスを伝送する、世界で初めての実証実験に挑戦しました。実証実験では双方向コミュニケーションが可能なほどの低遅延で、3D空間に加えて触覚情報までを伝送することで、まるで演者が同じ空間にいるかのような体験を実現しています。本稿では、実証実験で用いた「動的3D空間伝送再現技術」と「触覚振動音場提示技術」の2つの技術を解説します。また、それらの技術を用いて、ライブパフォーマンス伝送がどのように実現されていたか、舞台裏を紹介します。

動的3D空間伝送再現技術

動的3D空間伝送再現技術は、空間の“動的”な時間方向の変化、つまり「空間の動き」までを伝送する技術になります。ライブパフォーマンスを伝送しようと考えたとき、従来の動的な3D空間を計測する技術には、いくつかの問題点がありました。

1つは広い領域を精度高く計測するのが難しいことです。3Dデータを計測する方法にはMicrosoft KinectなどのRGB-Dカメラが知られています。しかし、RGB-Dカメラは、計測範囲が数mと狭いものが多く、さらに計測できる限界に近い距離では計測値の歪みも大きいため、RGB-Dカメラを複数組み合わせて広域を撮影・統合することは困難となります。

2番目の問題は、計測から表示までの低遅延性を保つのが難しいことです。RGB-Dカメラ以外の、一定領域を動的3D計測する方法として、もっとも商用化が進んでいる方法には、ボリュメトリックキャプチャ方式があります。ボリュメトリックキャプチャは、多数のカメラを対象の周囲へ配置することで、3Dデータを測定する手法ですが、多くのカメラ画像から3次元形状を推定・復元する処理が必要なため、遅延の比較的小さいものでも数秒程度の処理時間が必要です。一方で、電話やWeb会議などのような、双方向でコミュニケーションするシステムを違和感なく利用するには、片道200ms未満で計測から提示までを完了する必要があります。またボリュメトリックキャプチャは、スタジオなどの照明条件が一定で安定した環境が求められるため、曲や演者の動きに合わせて、激しい照明演出のある今回のライブパフォーマンスでは適用が困難でした。

NTT研究所が開発する動的3D空間伝送再現技術は、ボリュメトリックキャプチャのようにカメラだけを用いるのではなく、1台のカメラに3台のLiDAR(Light Detection And Ranging)*1を組み合わせた独自の計測装置(図1)で3D空間を計測します。図1の計測装置を複数セット用いて、すべてのカメラとLiDARをネットワーク経由で時刻同期制御することで、広域な空間の計測を実現します。計測に利用されるLiDARは、主に自動運転のために車載用途で利用されるもので、最大200 m離れた対象の位置情報を計測が可能です。また動的3D空間伝送再現技術では、カメラの画像データに、深度値が直接取得できるLiDARデータを組み合わせることで処理を軽くし、計測から表示までを短時間で実現しています。

カメラ・LiDARの時刻同期制御には、Precision Time Protocol (PTP)と呼ばれる、ネットワークを通じてナノ秒からサブマイクロ秒の精度で、機器の時刻同期を実現するプロトコルを利用しています。1つひとつのLiDARは、1秒間に10回の頻度でしか空間を計測することができませんが、3台のLiDARが空間を計測するタイミングを、PTPに基づいて30分の1秒ずつ変化させることで、1秒間に30回の空間計測を実現しています。このように複数のセンサデータを位置・時刻に基づいて、高い精度で一致・収集することは、別々のLiDARが計測したデータを1つの3Dデータとして正確に統合したり、色情報のないLiDARの3D点群*2データを、別センサであるカメラの画像で着色したりするセンサフュージョンでも重要となり、本技術を実現する土台となっています。

上記のとおり、カメラとLiDARを組み合わせることが特徴の本技術ですが、実現には多くの技術的な課題が存在しました。

課題の1つは、LiDARが計測する点群データはカメラ画像と比べて「疎」であるということです。一般的に、LiDARはレーザを走査線として発射し、送出先の物体表面に当たって戻るまでの時間で、対象の距離を計算するTime-of-Flight(ToF)という方法が用いられます。そのため計測可能な空間密度は走査線の数に依存しますが、現時点では密度の高いものでも128本程度になります。この本数は、カメラがFull HD画質でも水平方向に1080 pixの粒度で撮影できることを考えると、疎なことが分かるかと思います。

2番目は、複数台のカメラ・LiDARで計測するときに生じる、機器間のノイズやズレの問題です。複数のカメラ・LiDARで計測したデータを正しく1つに統合するには、各機材の位置関係を正確に取得し、さらに各機材の計測歪みを精緻に補正するキャリブレーションが求められます。しかし、キャリブレーションを完全に誤差なく実施することは難しく、誤差から生じる各点群データのズレや歪み、さらには点群データをカメラ画像で色付けするときの誤り対策が必要となります。

動的3D空間伝送再現技術では、「密度」と「ズレ・歪み」の問題を、独自の高密度化技術と、ノイズ除去技術で解決しています。高密度化技術では、従来手法の20倍高速な独自アルゴリズムを開発することで、低遅延でカメラ画像からLiDARの計測できていない領域の深度値を予測します。またノイズ除去技術では、高速に動く物体に発生する残像ノイズを除去する手法、カメラ画像から誤って色付けされた点群データを除去する手法、さらには多くのアングルから計測した3Dデータを1つに統合するときに、各計測機材のノイズ・歪みが蓄積して見た目が悪化することを防ぐフィルタ処理が施されています。

これらの研究成果により、動的3D空間伝送再現技術ではデータ計測から、高密度化・ノイズ除去を適用し、さらにデータを送受信して3次元情報として閲覧可能な状態にするまでを100ms未満で実現しました。そのため本技術は、違和感なく双方向コミュニケーションができるとされている片道200msの遅延値より大きくリアルタイム性が高まっています。また3D空間の計測密度やズレ・歪みの課題についても、NTTパビリオンの大画面の3D LEDディスプレイで違和感なく視聴できる水準を達成しています。

*1 LiDAR:レーザ光を照射し、その反射光の情報を基に対象物の3D形状を点群データとして計測する技術です。

*2 点群:3D空間に位置情報を持つ多数の点で記述するデータ表現形式。LiDARで計測された点群は色情報を持たず、色情報はカメラなど別のセンサで計測をする必要があります。

触覚振動音場提示技術

触覚振動音場提示技術は、地面の構造や形状、履いている靴、地面を踏む強さで変化する足元の触覚振動を、定位感も含めて計測し、離れた場所へ再現する技術です。例えば、今回のライブパフォーマンスでは、木製ステージの上を、ブーツを履いたPerfumeが、キレのあるダンスで踏みしめる足元の質感・感触を、あたかも同じステージにいるかのように伝えることができます。また定位感を含めた計測・再現とは、振動を発生させる対象の位置が変化したときに、振動を感じる側が、その位置変化を感じられるように再現することです。例えば、パフォーマーが左右に動いたときに、触覚振動も右・左それぞれの方向から伝わるように伝達できる技術となります。

従来技術では、触覚振動の計測には、床下へ多数のマイクをアレイ状に並べる手法が一般的でした。しかし、マイクを埋め込む手法は、アリーナやステージの床を二重にして、多数のマイクを設置や、信号を収集する配線を実施するなど、施工・構築コストが大きくなる問題があります。また、今回のようなライブパフォーマンスでは、床のマイクが触覚振動だけでなく、楽曲の音まで計測してしまうため、取得したい信号だけを明瞭に計測できない問題がありました。そこでNTT研究所では、独自の小型無線センサ(図2)を開発し、開発したセンサを足元へ直接取り付ける手法を実現しました。また開発した小型無線センサには、空気の振動を音として計測する一般的なマイクではなく、加速度を計測するセンサを採用しています。加速度センサを用いることで、マイクを使う方法とは異なり、ダンス中の楽曲のような環境音の影響を受けずに、触覚振動を計測することが可能になります。一般的に、加速度で触覚振動を計測すると「ブーツが固い木の上をコツコツと叩く感触」のような“振動の質感”が、マイクと比べて失いやすい問題があります。しかし、本技術では振動の再現時に周波数別に強調・抑制を制御することで、加速度データでも質感の再現を実現しています。

またNTT研究所では、定位感を含めて振動を再現するため、振動が発生した場所を追跡するトラッキングシステムを新たに開発しています。具体的には、カメラによるマーカーレスのトラッキングと、独自設計の自発光マーカーによるトラッキングの2つを組み合わせる手法を開発しました。本手法により、今回のパフォーマンスのように、計測対象が頻繁に移動して、交互に場所を入れ替える環境でも、トラッキング対象を一度も見失わないロバスト性を実現しました。

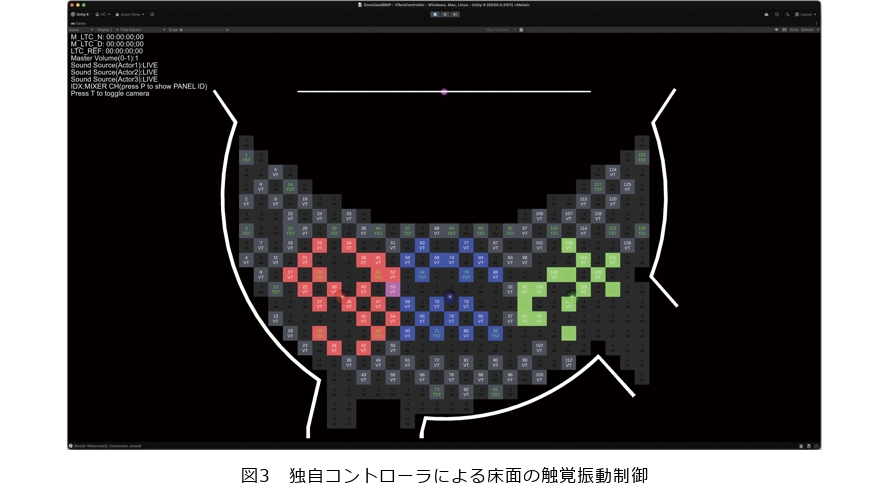

さらに計測した位置情報付きの触覚振動を、大規模な環境で、効率的に再現するところにもNTT独自の技術が用いられています。NTTパビリオンは最大70名が同時に体験するため、体験スペースに敷き詰められる50cm×50cmのOAフロア床(フリーアクセスのタイル)は352枚にものぼります。厄介なことにタイルどうしは振動が伝達されないため、体験スペースのどこでも振動を体験可能にするには、すべてのタイルに振動子を取り付ける必要が出てしまいます。そこでNTT研究所では、独自の振動伝搬層を追加する床設計を開発し、振動子の数が約3分の1になっても、前後左右に斜めも加えた8方向の定位感を維持して、迫力ある振動を再現することを実現しました。さらに独自開発した振動コントローラ(図3)を用いて、計測した振動源の位置に応じて、どのタイルの振動子を揺らすかを制御することで、全体が一様に揺れる表現や、演者の位置関係に応じて振動場所が変わる表現など、さまざまな振動演出が実現されています。

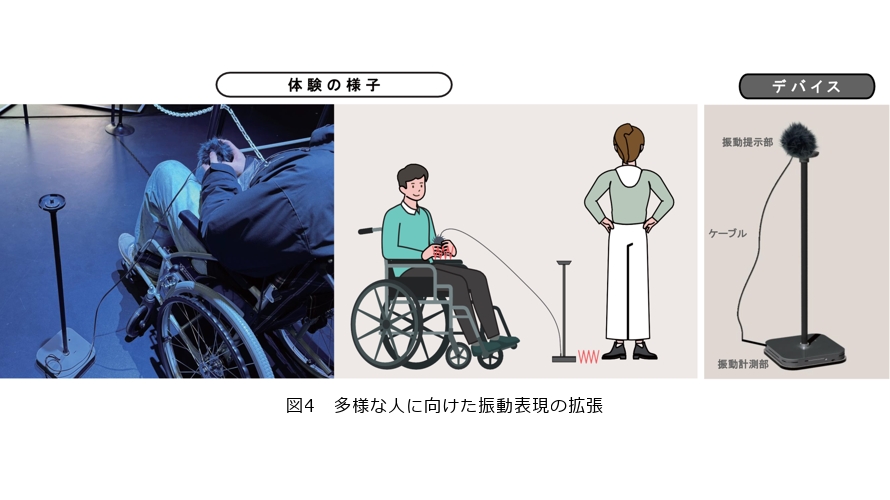

またNTT研究所では、車いすの方でも不自由なく体験できる工夫として、手でも振動を感じられるデバイスを開発しました(図4)。本デバイスは、近くの床の振動を計測して、手で持つデバイスへ振動を伝達するシンプルな構造となっているため、利用者が体験する位置によらず、柔軟に対応できるようになっています。

実証実験の舞台裏

ライブパフォーマンスを伝送する実証実験は、大阪万博(EXPO’70)が開催された吹田市の万博記念公園の電気通信館跡地と、夢洲の大阪・関西万博のNTTパビリオンを接続して、2025年4月2日に実施されました。2つの場所は、NTTパビリオンの体験テーマである“PARALLEL TRAVEL”に合わせて、1970年と2025年を象徴する拠点として選定され、直線距離で約20kmの区間をNTT西日本が提供するAll-Photonics Connect powered by IOWNを使用することで、データ伝送を実現しています。

万博記念公園では、10m×15mのテント内にパフォーマンスをするためのステージを構築しました(図5)。ステージの周囲には、動的3D空間を計測する7セットの計測装置、振動位置をトラッキングする28台のカメラ、さらにはステレオ映像を撮影する4K解像度の3Dカメラが4セット設置されました。またPerfumeの3人の声はピンマイクで、足元の触覚振動は、両足のブーツの裏に取り付けた3セットの振動センサで計測をしました。

2つの場所をIOWN APNで伝送した動的3Dデータ、触覚振動データ、ステレオカメラデータ、音声データの総伝送量は25Gbit/sにのぼり、動的3Dデータは研究所独自のデータ形式で1秒間に4500万点を伝送しました。またステレオ映像の伝送は4K60pの映像を、IP(Internet Protocol)ベースの映像伝送規格で業界標準であるSMPTE2110で実施し、触覚振動・音声データは音声信号を低遅延でIP伝送できるDante規格で伝送しました。

またデータを受信・再現するNTTパビリオンでは、動的3Dデータとステレオカメラデータを、事前にボリュメトリック撮影した“過去のPerfume”である3Dデータと融合させながら、横幅13.2m・高さ4.8mのヒビノ社が取り扱う3DLEDディスプレイシステム「Immersive LED System」*3(図6)へ表示することで、迫力ある表現を実現しました。伝送した動的3Dデータには、リアルタイムでカメラワークや光の粒子などの演出を追加することで、動的3Dデータを活かした表現を実現しています。また触覚振動は、3DLEDディスプレイに立体的に表示される演者の位置に合わせて、床に設置した128個の振動子を制御することで、視覚・聴覚に加えて触覚が組み合わさったライブ体験を実現しました。

本実験の準備は、万博記念公園にテントを設置した3月中旬からライブ本番までの3週間弱にかけて、特に集中して進められました。同期間は、万博記念公園側のメンバと、NTTパビリオンのある夢洲側のメンバに分かれて作業を進めることになりましたが、映像・音声・照明などの演出に必要な機材は、IOWN APNを通じた制御によるリモートプロダクションで実施することで、各担当が2つの会場を往復する回数が大幅に減り、効率的に作業を進めることができました。

本伝送実験は、1度きりのライブパフォーマンスとして、NTTパビリオンに招待した多くのメディア関係者の前で披露しました。また同ライブ伝送の様子は、特設サイトを通じてYouTubeにもライブ配信しています(1)。また約7分間のパフォーマンス後には、NTTパビリオンと万博記念公園にいるPerfumeとの間で、掛け合いをする双方向コミュニケーションも実施しており、2つの場所の距離を感じさせない低遅延で、視覚・聴覚に五感も加わったIOWNによる未来のコミュニケーションの可能性を感じていただくことができました。

本実験のライブパフォーマンスの様子は、4月2日にライブ伝送したままの状態で保存しており、万博期間中は当日の様子を追体験できるコンテンツとして、NTTパビリオンのZone2で体験できます。

*3 Immersive LED System:専用の3Dメガネを装着することでステレオ立体視ができる 3DLEDディスプレイシステム。本実験ではパッシブ方式の3Dメガネで視聴できる3DLEDディスプレイシステムを利用しています。

今後の展望

本稿で紹介した動的3D空間伝送再現技術・触覚振動音場提示技術は、高臨場な体験を届けるスタジアム・アリーナ向けソリューションへの応用可能性があると考えています。また計測したデータをサイバー空間上でも利用可能にすることで、メタバース向けのコンテンツとして人が体験するだけでなく、自動運転や社会インフラの維持管理など、多様な産業分野のサイバー空間での予測・分析・シミュレーションに利用するなど、さまざまな活用の可能性があると考えています。

(後列左から)村崎 和彦/山口 真理子

望月 崇由/島村 潤

松元 崇裕/駒﨑 掲

千明 裕/吉田 大我

谷田 隆一/青木 政勝

(前列左から)鈴木 督史/草深 宇翔

小長井 俊介

本稿の空間データ伝送実験の様子は、YouTubeでもご覧いただくことができますが、実際にNTTパビリオンで体験すると、臨場感の全く違う体験となっています。未来のコミュニケーションを感じられる特別な体験となりますので、皆様ぜひ会場まで足をお運びください。